デジタルツインについて言及をする 今後のデジタルとの向き合い方について考えていきます

Physical Intelligence最前線:

人・ロボティクス・デジタルツインの共創

当セミナーの概要

当セミナーの主題:

フィジカル・インテリジェンス(Physical Intelligence)最前線:

人・ロボティクス・デジタルツインの共創

運営主体:

当セミナーは以下の運営主体が共催し実現した。

●東北大学大学院工学研究科技術社会システム専攻

●東北大学タフ・サイバーフィジカルAI研究センター(TCPAi)

●株式会社現代経営技術研究所(現研)

講師/パネリスト:

田所諭氏 東北大学大学院情報科学研究科応用情報科学専攻教授

東北大学タフ・サイバーフィジカルAI研究センター長

井川玄氏 千代田化工建設㈱ 参与 フロンティアビジネス本部 デジタル担当

泉秀明氏 東北大学大学院工学研究科技術社会システム専攻 ㈱現代経営技術研究所 シニアコンサルタント

司会:大槻裕志 ㈱現代経営技術研究所 所長

<講師>

田所 諭(たどころさとし)氏

東北大学 大学院情報科学研究科 応用情報科学専攻 教授 東北大学タフ・サイバーフィジカルAI研究センター長。1984年,東京大学工学系大学院修士課程修了。1993年,神戸大学助教授。2002年~,国際レスキューシステム研究機構会長。2005年~,東北大学教授。2014年,同副研究科長。2019年~,同タフ・サイバーフィジカルAI研究センター長。2014~18年,内閣府ImPACTタフ・ロボティクス・チャレンジプログラムマネージャー。2016~2017年,国際学会IEEE Robotics and Automation Society President。科学技術分野の文部科学大臣表彰科学技術賞他受賞。レスキューロボットの研究に従事。博士(工学).IEEE Fellow。

井川 玄(いかわしずか)氏

千代田化工建設㈱ 参与 フロンティアビジネス本部デジタル担当。千代田化工建設入社後、制御システムエンジニアとして国内プラントの設計及び工事を担当後、アジアや中東でのプラント建設プロジェクトに従事。カタール国の世界最大級のLNGプラント建設においては、コミッショニングマネージャーを歴任。2012年、カタール国でのグループ会社CEOに就任。2016年に帰国し、AIソリューション部設立からDXビジネス開拓に携わり、現在に至る。慶応義塾大学理工学部卒。

泉 秀明(いずみひであき)氏

東北大学 大学院工学研究科 技術社会システム専攻特任教授。現代経営技術研究所(現研)シニアコンサルタント。

清水建設、外資系大手製造会社2社の役員を経て、関西学院大学経営戦略研究科特任教授、山口大学技術経営研究科教授、京都大学経営管理大学院客員教授を経て現職。

東北大学工学部機械工学科卒、ワシントン大経営学・工学修士、バージニア大学EMBA、神戸大学経営学研究科博士(経営学)。主な著書『米国の合理と日本の合理』(2019)白桃書房。

<司会>

大槻 裕志(おおつきひろし)

現代経営技術研究所(現研)所長

当セミナーを読み解くため共有したいこと-フィジカル・インテリジェンスについて

司会:大槻裕志

今回の共催セミナーのタイトルは、「フィジカル・インテリジェンス(Physical Intelligence)最前線:人・ロボティクス・デジタルツインの共創」である。

フィジカル・インテリジェンスとは田所氏が提唱している概念である。フィジカル・インテリジェンスとは何か?氏は次のように定義している。

自律機能を備えたロボットがネットワークのハブとなり、デバイス、センサー、ソフトウェア、AIとつながっている状況を前提に、ロボット単体の知能ではなく、人間を含むヘテロジニアス(異種多様)な知能体が実現する集団知能である。

氏は「ヘテロジニアス(異種多様)な知能体が実現する集団知能がタフネスを獲得することを通じてロボティクスが実社会、現実の世界の役に立つ存在へと進化していく」と語る。

ではタフとは何か?

実世界で稼働するAIは、無限定で様々な擾乱(じょうらん)に晒された環境下で、サイバー・フィジカルな“身体性”をもって実世界と関わる。また、“身体”の有限性から取得できるデータ規模、定常性、品質などに制約を受けることになる。このような過酷な条件下で安定に高品質で動作するロバスト性や柔軟性と適応性、そして広い適用性をタフと呼ぶ。

以上がタフの定義となる。

フィジカル・インテリジェンスならびにタフということを強調するのは、「AIによる頭脳労働は急速に進化し、できることがどんどん拡大、高度化している。一方で、実世界においてAIが実現できている肉体労働は極めて僅かなことしかない」(田所氏)という現状認識からである。

AIを活用しロボットの自律機能を向上させてロボティクスに実世界で人の役に立つ活躍をさせたい。本日の3人の講師/パネリストは、そのような想いを共有しており、フィジカル・インテリジェンスの最前線に立ち、それぞれの立場から道を切り拓いている。

田所氏はタフ・サイバーフィジカルAI研究センターを率いて極限の災害現場でも自律機能を発揮しタフに動くレスキューロボットを開発し社会実装するために、井川氏は千代田化工建設が培ったエンジニアリング技術にAI&デジタル技術を融合させて産業の未来を拓くプラントデジタルツインをどこよりも早く実現するために、泉氏はアカデミズムのロボット研究の成果を産学連携のレールに乗せるために挑戦を続けている。

当セミナーでは、3人の講師がそれぞれの最前線の取り組みをリポートし、そのリポート踏まえてパネル・ディスカッションを実施する。3人によるリポートとパネル・ディスカッションを通じて、本日のセミナータイトル「フィジカル・インテリジェンス最前線:人・ロボティクス・デジタルツインの共創」に込められてメッセージが皆様に伝わることを確信している。

Ⅰ.産学連携で切り拓くフィジカル・インテリジェンスの未来

東北大学大学院工学研究科 技術社会システム専攻 特任教授

現研シニアコンサルタント 泉 秀明

最初に私から、“産学連携で切り拓くフィジカル・インテリジェンスの未来“という内容で話をさせていただき、問題提起をしたいと思います。

日本は世界最大の産業用ロボット生産国なるも、論文数では7位に転落

ロボットには、大きく分けて「産業用ロボット」と「サービスロボット」が存在します。

産業用ロボットは一般に生産工場で機能しているロボットです。川崎重工業の分類によれば、6種類の基本型が存在します。

1.産業用ロボットの元祖である極座標型ロボット

2.50年の長い伝統を持つ円筒座標型ロボット

3.制御がシンプルである直角座標型ロボット

4.スカラ型と呼ばれ、組み立てに用いられる水平多関節型ロボット

5.どんな動きでも可能である垂直多関節型ロボット

6.とにかく早く動くパラレルリンク型ロボット

一方の「サービスロボット」は、最近あちらこちらで見られるようになってきました。国際ロボット連合の分類によれば、以下の5種類に分類されます。

1.自立走行搬送ロボット

2.清掃、消毒用ロボット

3.医療、リハビリロボット

4.人と双方向でのコミュニケーションが可能なテレプレゼンス型ロボット

5.料理をしたりする自動化レストランロボット

これらは様々なサービス提供の場で使用され始めています。

日本は世界最大の産業用ロボット生産国です。ファナック、安川電機、川崎重工、ヤマハ発動機、エプソン、不二越など、皆さんもご存知だと思います。世界の設置済み産業用ロボットの50%が日本製であり、2020年においては45%が日本で生産されています。生産されたロボットの78%が輸出され、そのうち中国向けが36%となっています。輸入はわずか2%しかありません。

2020年に輸出された産業用ロボット設置数は、1位 中国 168,400台、2位 日本 38,700台、3位 米国 30,800台、4位 韓国 30,500台となっています。また、ロボット設置密度というような指標を社員10,000人あたりの設置数でみると、2020年においては、1位 韓国 932台、2位 シンガポール 605台、3位 日本 390台、9位 中国 246台となっており、人口密度が高い国が上位となっています。中国は9位です。

しかしながら、その日本にも陰りが見え始めているようです。世界的に最も権威がある“International Conference on Robotics and Automation”への提出論文数において、10数年前には米国と共に論文数でトップ水準にあった日本は、2019年には7位に転落したのです。

2020~2025年でサービスロボット市場は倍増する

今後拡大が期待されるサービスロボット市場は、2020年から2025年の間で倍増すると予想されています。それに伴い、各種サービスロボットの普及が進むと言われており、2025年以降もその傾向は顕著になると予想されています。時々ランチへ行く焼肉レストランで半年前から配膳・搬送ロボットが使われ始め、また、事務所ビルなどでは昨年から清掃用ロボットが見られるようになっています。

背景として、ここにあげるように、自動化、省人化、業務負担の軽減、コロナウィルス感染対策を機に高まった非接触対応、在宅勤務への推進などがあります。富士経済が行ったサービスロボットの分類は、国際ロボット連合の分類と比較して、若干の違いがあり、以下のように分類されています。

⚫︎家庭用:スマートスピーカーや家庭用清掃ロボット

⚫︎建設/物流 搬送 /レスキュー/インフラ/農業用:

空撮、農薬散布、測量、構造物点検、配送用にドローン・無人ヘリ(UAV)

製造・物流業で省人・無人化に向けて自動搬送車(UGV)

⚫︎医療・介護用:パワーアシスト・増幅スーツ、紫外線照射ロボット

⚫︎オフィス、店舗用:搬送・受付用等テレプレゼンスロボット、清掃・調理ロボット

⚫︎AI/RPA: ①疾病診断支援ロボット、②コールセンター支援ロボット③金融ロボット、④RPAソリューション

日本の競争力復活の鍵はサービスロボットのスマート化にある

産業用ロボットは日本のお家芸と言われるものでしたが、自動車同様に中国、韓国から追い上げを受ける中、サービスロボットの育成が今後のロボット産業の発展の課題となっています。

これまでの日本のロボティクス時代は、“長期の奇跡的経済成長、自動車製造業の台頭、戦後の労働力不足”等、産業用ロボット大国として成長できるような、経済的・社会的背景がありました。これからのロボティクス時代は、“少子高齢化・人口減少による労働力不足、デジタル技術との統合、日常生活への適用深化”というように、経済的・社会的背景が変化し、サービスロボットが社会の原動力として機能する時代になって行くと予想されています。

従ってビジネス上の重要な成功要因として、サービスロボットに関わるモノ・コトにおいてどのように差別化を図ることができるのかということが課題になってきます。ご存知のように少子高齢化・人口減少の下での生産性向上は、日本企業が克服すべき経営上の問題点として挙げられていますが、サービスロボットの育成はこの解決策としても一石を投じるものであると期待されています。

ソフトバンクグループの総帥である孫正義氏は、“日本の競争力復活の鍵は、サービスロボットのスマート化、いわゆるスマボにある”と明言しています。スマート化の源泉は様々なデジタ

ル技術であり、スマートロボットは様々なデジタル技術と連携して発展することが予想されています。

千代田化工建設を始めとする日本の大手プラントエンジニアリング会社や、その客先である石油化学会社が構想を掲げているものに、“プロセスプラントの無人運転・保守・保全のスマート化構想”があります。先ほど説明した、少子高齢化・人口減少による労働力不足や安全対応として、主に人に頼ってきたプロセスプラントの運転・保守・保全を、“サービスロボットと様々なデジタル技術”を使用して実施する、新たな運転・保守・保全構想です。

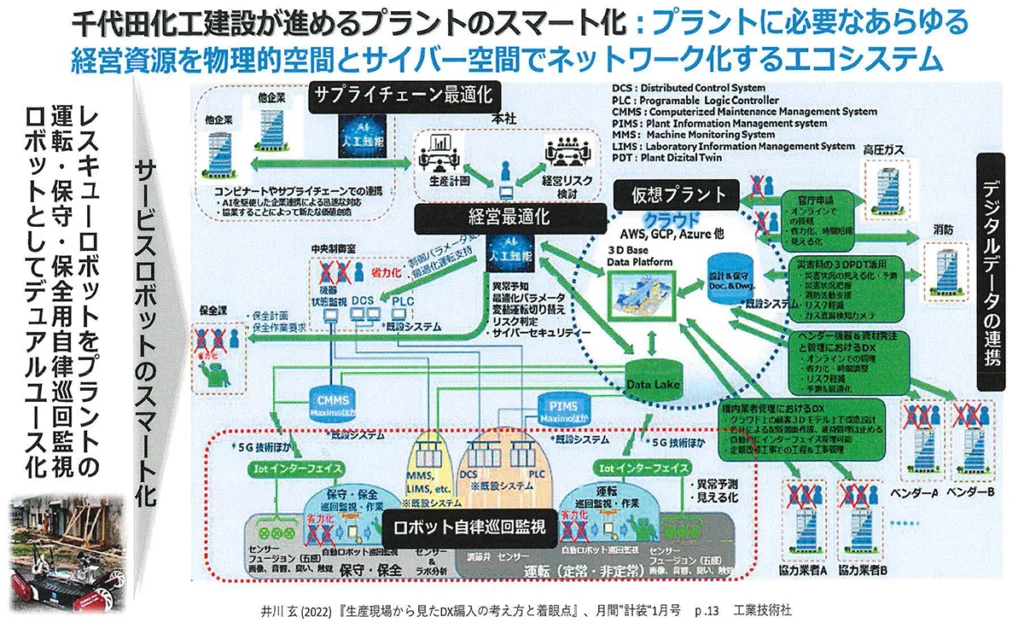

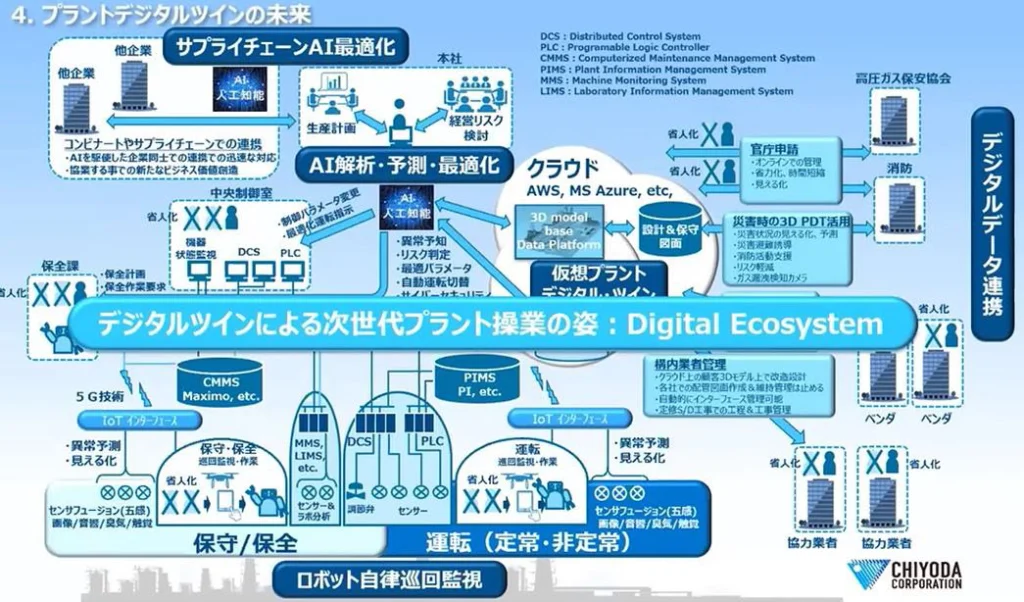

千代田化工建設が進める、“未来のプラント操業のスマート化概要”(井川玄氏作成)は、下図の通り“プラント操業に必要なあらゆる経営資源を、Roboticsを含めたフィジカルな空間とサイバー空間でネットワーク化するエコシステム”となっています。この図から、本日のテーマである“フィジカル・インテリジェンス(Physical Intelligence)最前線:人・ロボティクス・デジタルツインの共創”のプラント産業における展開を読み取ることができます。

このエコシステムの中でリアルのプラントを自律巡回監視するロボットが運転・保守・保全の重要な役割を担います。この自立巡回監視として稼働しているこのロボットがプラントの事故・災害時にはレスキュー・ロボットとして機能することが構想されています。

“レスキュー・ロボットをプロセスプラントの運転・保守・保全用の自律巡回監視ロボットとしてデュアルユース化”する試みは、サービスロボットを様々なデジタル技術の環境下においてスマート化して使用する典型的な例であり、田所教授が主張される“Physical Intelligence”、つまり、「自律機能を備えたロボットがネットワークのハブとなり、デバイス、センサー、ソフトウェア、AIとつながっている状況を前提に、ロボット単体の知能ではなく、人間を含むヘテロジニアス(異種多様)な知能体が実現する集団知能」の社会実装の最適な例になるのではないかと思います。

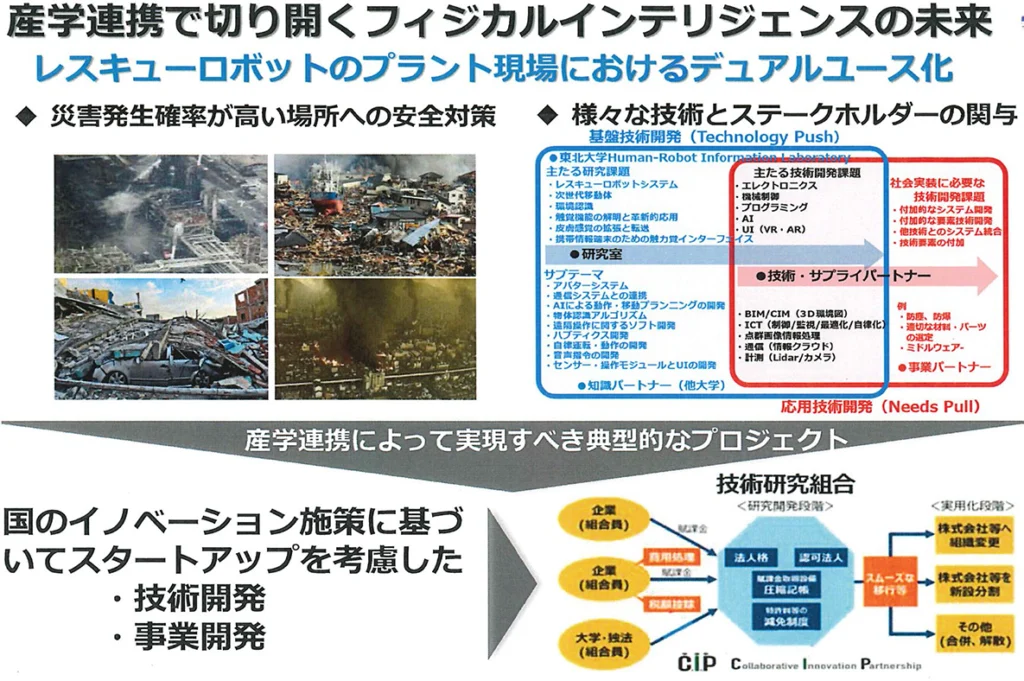

産学連携でレスキュー・ロボットのデュアルユースの実現へ

それでは、“レスキュー・ロボットをプロセスプラントの運転・保守・保全用、自律巡回監視ロボットとしてデュアルユース化”する試みをどのように展開させていくべきでしょうか。

南海トラフ大地震が向こう30年に70%の確率で発生すると予想され(2024年時点の予測)、海岸部にプロセスプラントが集中する日本においては、公共的な安全対策が求められています。レスキュー・ロボットをデュアルユース化するには、様々なシステムを統合する技術開発、事業開発を必要とし、これらを企業一社で対応することは難しく、多くの企業、ステークホルダーの関与を必要とします。

このようなプロジェクトは、大学・企業が共同で取り組む典型的な産学連携プロジェクトであり、有効な組織の代表的な枠組みの例として“技術研究組合”というものがあります。これはイノベーションの創発を目的として、大学発ベンチャー・スタートアップを促進する国の施策に基づくもので、産学連携で研究開発、事業開発を行う組織です。企業・組織のサイズに関わらず一組織一組合員を形成することができ、税制上の対応等についても、非常に柔軟性を持っています。

2019年から2022年まで、大学発ベンチャー創出を目的とする京都大学インキュベーション・プログラムにおいて、私は京都大学理工学研究科の松野文俊教授(現在は大阪工業大学工学部教授)と共に、主に建設・エンジニアリング分野で”レスキュー・ロボットのデュアルユース化”を実現させることを目指して事業開発に従事しました。

技術研究組合の組織化を目論みましたが、コロナウィルス感染対策が主たる理由で、活動に制限を受け期間内に実現させることができずにプロジェクトは終了しました。松野先生の盟友で、最先端でレスキュー・ロボットの研究開発を進めておられる本日の講師の田所先生が”レスキュー・ロボットのデュアルユース化”を実現されることを期待しています。

ロボット、デジタル技術を駆使した“プロセスプラントの運転、保守、保全のスマート化”は、多様な技術イノベーションを必要とする重要な国家戦略となっています。中国やドイツをはじめとする海外の企業で開始されていますが、技術的にはまだ未発展の段階のようです。

今後日本では、多くの大学、企業が参加・結集して、“レスキュー・ロボットをプロセスプラントの運転・保守・保全用自律巡回監視ロボットとしてデュアルユース化” するための技術開発、事業開発のプロジェクトが、産学連携によって実現されることを祈念しています。それによりロボットのスマート化を高度な形で実現し、フィジカル・インテリジェンスを社会に実装する突破口になるものと確信しています。

以上、私からは“産学連携で切り開くフィジカル・インテリジェンスの未来”を本セミナーの問題提起としたいと思います。

Ⅱ.フィジカル・インテリジェンス(PI)の展開構想

東北大学大学院情報科学研究科応用情報科学専攻 教授

東北大学タフ・サイバーフィジカルAI研究センター長

田所諭氏

はじめに

現状のAIに感じる違和感~フィジカルに根差したインテリジェンスとは

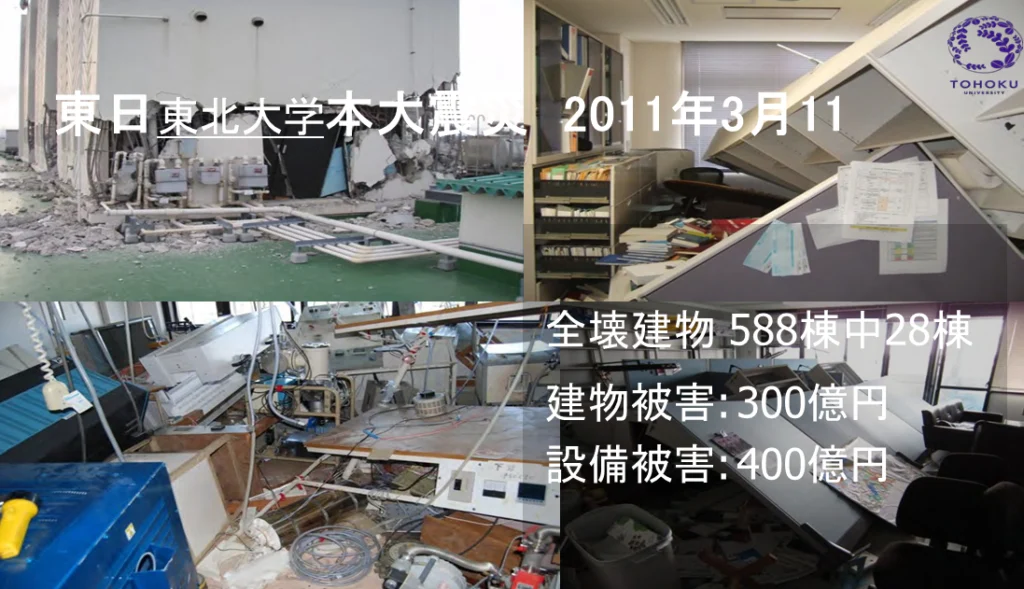

私はレスキュー・ロボットという、災害時に人命を救助したり、あるいは人の役に立つ活動をしたりするロボットの研究開発を続けてきました。神戸大工学部助教授だった1995年、阪神淡路大地震を経験し、壊滅状態に陥った神戸の街に立って、研究者として、災害救助で活躍するロボット、人命を救うロボッ トを作らねばならないと決意しました。以来、ロボットテクノロジーをレスキューに活用する研究に乗り出しました。

これをもう少し砕けたかたちで言います。ガンダムや鉄人28号のような正義の味方のロボットをつくりたかったのです。それが正直なところです。

インテリジェントに動くロボットを実現しようとしている立場から言うと、そのキーワードにAI(Artificial Intelligence)を挙げることには、大きな違和感を覚えています。

Artificial Intelligenceと言いながら、現存するロボットは、実はIntelligence in Artificially Structured Worldに過ぎないのです。要するに、人工的に作り上げられた環境の中で、それなりに気の利いたことを自動的にできる程度のレベルにしかない、というのが今のAIです。ディープ・ラーニングなどを用いて、フィジカルな世界とサイバーの世界がより密接に結びつくようになってはきましたが、これを実際に現場で使おうとした時には依然として厳しい部分が多い。もっと真剣にフィジカルに根差したインテリジェンスを考える必要があるんじゃないか、というのが私の主張です。

本日の講演では、私が取り組んできたレスキュー・ロボットをご紹介した後、そこでの問題点や、それに対してインテリジェンスをどのように考えていったらいいのかを、ここで議論をしてみたいと思います。

災害時におけるロボットの役割とは

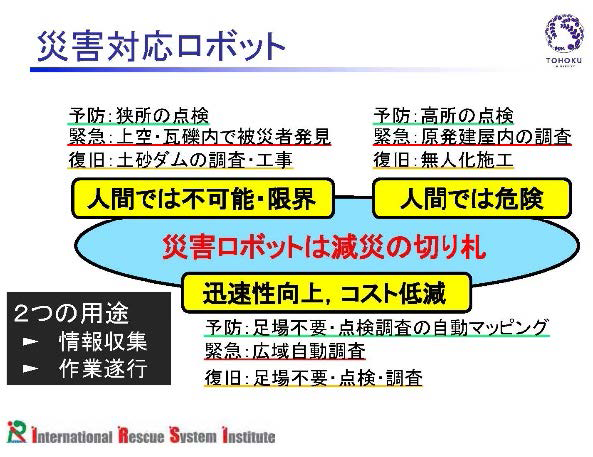

災害時におけるロボットの役割は以下のように整理されています。

「遠隔自律機能により、人間の仕事を代替することによって、困難な仕事を可能にする」

レスキュー・ロボットの役割には、災害の予防や緊急対応、災害の復旧などがあります。特に人間には対応が不可能であったり限界があったりする所、例えば狭い所を点検したり、あるいは上空や瓦礫内で被災者を発見したり、またあるいは土砂ダムなどの調査や工事を行ったりするというものになります。

ロボットの役割を災害救助という観点からもう少し詳しく考えてみる必要があります。

国連のOCHA(国連人道問題調整事務所 Office for Coordination of Humanitarian Affairs)という組織の中にUSAR(都市型捜索救助チーム Urban Search and Rescue)という組織があります。これは災害救助を行う人たちのグループで、このグループが主導する形で様々な救助活動の国際的な標準化や普及活動に取り組んでいます。このOCHAが2020年に、災害救助の捜索救助をどのように進めるかという国際標準ガイドラインを定めています。

以下のように、ASR(新アセスメント手法 Assessment, Search and Rescue)レベル1からレベル5の分類がなされています。

- レベル1:広域の災害現場の評価

- レベル2:作業現場のトリアージ評価

- レベル3:迅速な捜索活動

- レベル4:全面的な捜索救助

- レベル5:全範囲をカバーする捜索と復旧

このように、レベルを5段階に分けて災害対応を進めていく手順が国際的な標準となっています。日本の災害対応は若干標準から外れた活動を行っているように見えるかもしれませんが、基本的にはこの標準に準拠しています。

このASRレベル1からレベル5で当面する災害救助のあり方を検討し、このレスキュー・ロボットはどこにどのように組み込まれて、どのように救援活動全体に貢献するべきかを明らかにしなければなりません。災害対応のレベルに応じてそれぞれの現場でのユーザーの要求に合ったソリューションをどのように提供していくのか。レスキュー・ロボットごとに役割が定義される必要があります。

1.レスキュー・ロボットの社会実装への挑戦

私自身は、冒頭に述べました通り、阪神・淡路大震災でひどい目に遭い、災害現場で使えるロボットを造りたいと切に願い、レスキュー・ロボットを始めました。当時は世界中のどこを探しても、レスキュー・ロボットを本格的に研究している研究者はいませんでした。それはSFの世界の話だと思われていました。このままでは次の大震災が起こった時に人の命を助けられない、なんとかしなければならない。そういう想いを共有した有志が力を合わせて草の根から始めようと動き出したのです。

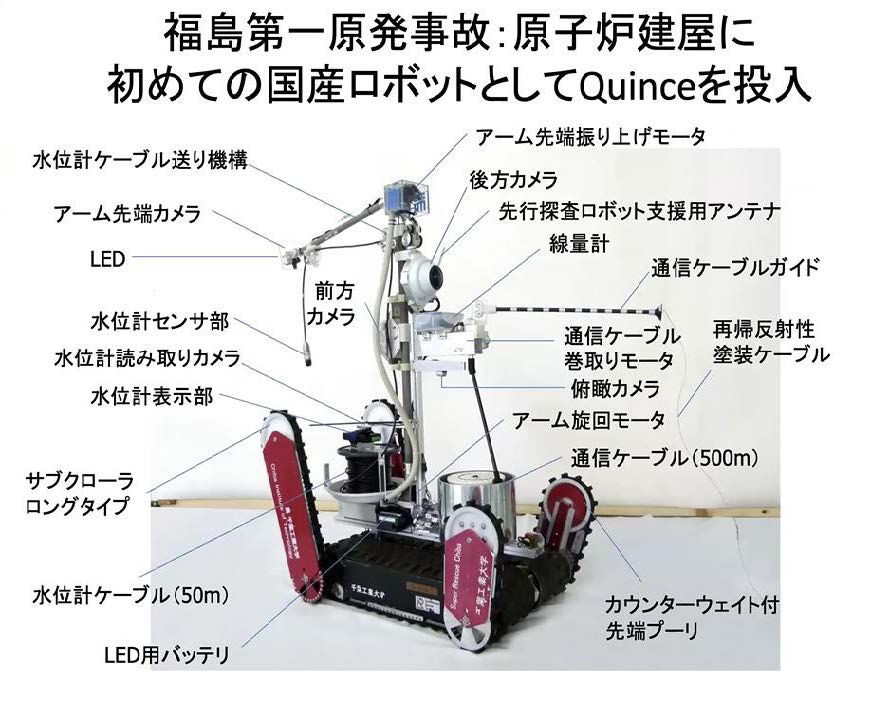

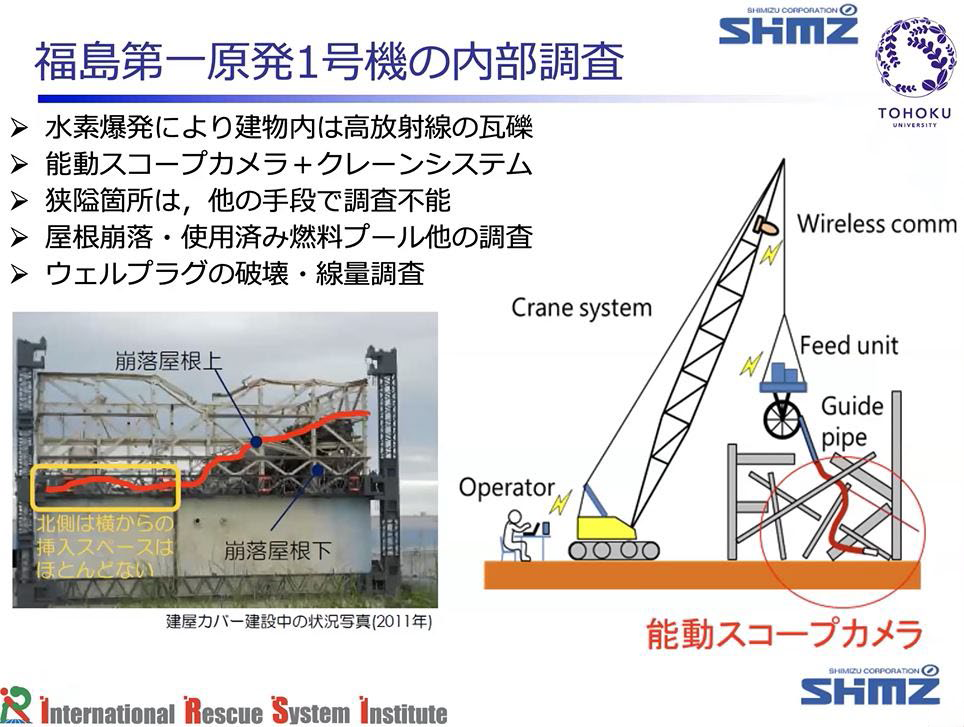

福島第一原発に初めて投入された国産ロボット“Quince”

2002年から文部科学省の大都市大地震軽減化特別プロジェクト(大大特)というプロジェクトを皮切りにして様々なレスキュー・ロボットの研究開発の旗を振る役割を果たしてきました。今振り返りますと、この大大特というプロジェクトがその後のレスキュー・ロボットの開発に与えた影響は非常に大きいと思います。例えばQuince(クインス)のような福島原発で活躍したロボットの元をつくり、瓦礫内の捜索ロボットやドローンを研究して、ロボット防災の扉を開く役割を、22年前に行ったこの大大特プロジェクトが果たしたと考えています。

写真はQuince(クインス)というロボットです。多くの方がご存知かもしれませんが、福島第一原発事故で原子炉建屋内に初めて投入された国産ロボットです。

Quinceは、東北大学、千葉工業大学、国際レスキューシステム研究機構、その他幾つかの組織が共同で研究開発をしていました。このプロジェクトが終わる段階になって福島原発の事故が起きました。その当時、これ以外のソリューションが無いという状況の中で、このロボットを提供して何らかのお役に立つことができました。

私はそれまで原子炉を想定した研究をやったことがなかったので手探りにならざるを得なかったのですが、原子炉建屋内の厳しい環境の中で動き回って情報収集するというニーズに対して、線量マップをつくったり、ダストサンプリングをしたりして、このロボットがお役に立ててよかったと思っています。

その当時、日本のロボットはどうしたのかとお叱りを受けることにもなりました。しかしながら、日本では災害に対しての備えをしていなかったのだからそんなロボットがある筈もなく、私のような門外漢がしゃしゃり出てお役に立ったというのは、むしろ変な話だったなと思わざるをえません。

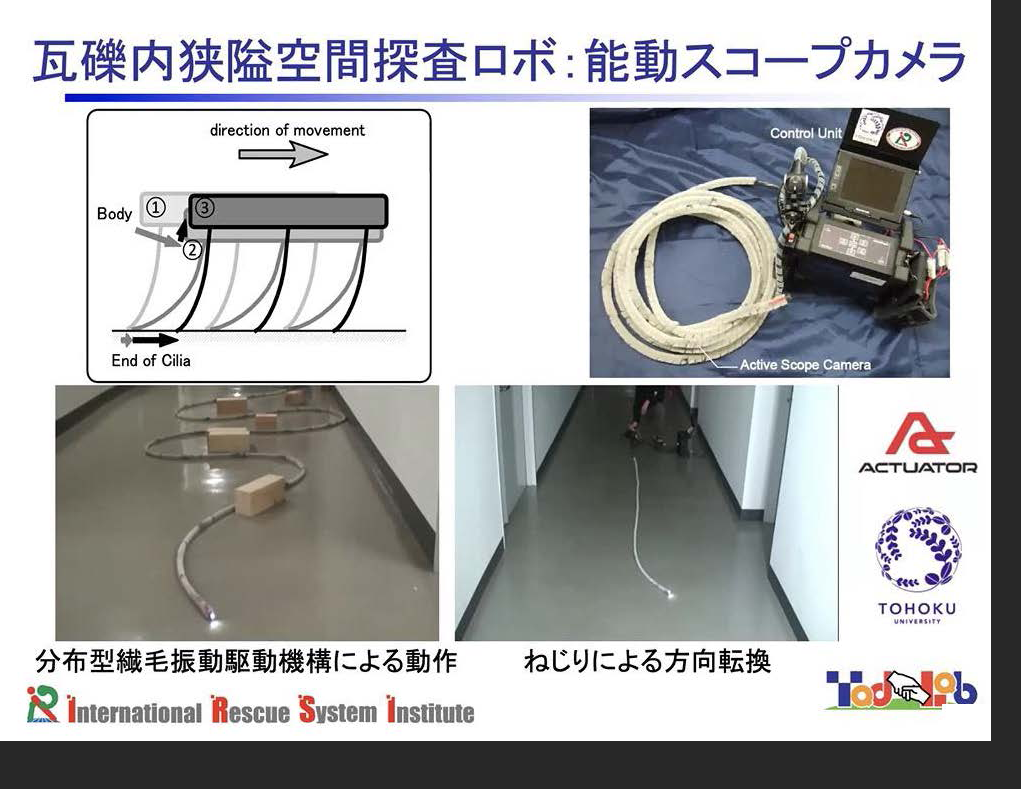

瓦礫の中を突き進む索状ロボット “能動スコープカメラ”

その後、2014年からImPACTタフ・ロボティクスチャレンジという内閣府のプロジェクトを主導しました。

そこでの主要な概念が、「タフ」です。

タフな技術をつくる。タフなロボットをつくることによって災害へのソリューションが得られる。そう考えて以下の5種類のロボットの研究開発を行いました。

- 1.飛行ロボット

- 2.脚ロボット

- 3.索状ロボット

- 4.サイバー救助犬

- 5.建設ロボット

私はタフでへこたれないロボット技術をつくることで問題を解決したいのです。その挑戦の一つとして索状ロボットを開発しました。

索状ロボットとは、この写真のヘビのようなロボットのことで、能動スコープカメラと通称されます。ビデオスコープカメラのケーブルの周りにアクチュエーターがついていて、自走式で狭い場所に入っていくロボットです。今から20年ほど前に研究開発し、狭いところにどんどん入ってく技術をつくって製品化もされましたが、それほど売れた訳ではないようです。

具体的に災害現場に適用された事例ですが、駐車場建設現場の倒壊事故において、なぜ倒壊が起きたかという原因調査を行いました。調査担当者がロボットを操作して穴の中にカメラを入れて映像を撮って、事故の原因調査を行ったのです。

福島原発にも使われました。清水建設との協力で、クレーンで吊った能動スコープカメラを災害現場の中に入れたのです。

瓦礫下の屋根構造の状態把握が非常に重要でしたので、ボアホールを開けて、その中に能動スコープカメラを突っ込んで、中の映像を撮りました。また、ウェルプラグという構造がどれだけ壊れているかを調査する必要があり、その場所の線量調査を行いました。

このロボットは原子力発電所用ではなくて災害救助用として開発したものなのですが、実はこれまで災害救助に役立ったことはなく、役に立ち実績を上げるのはこのような調査ばかりででした。

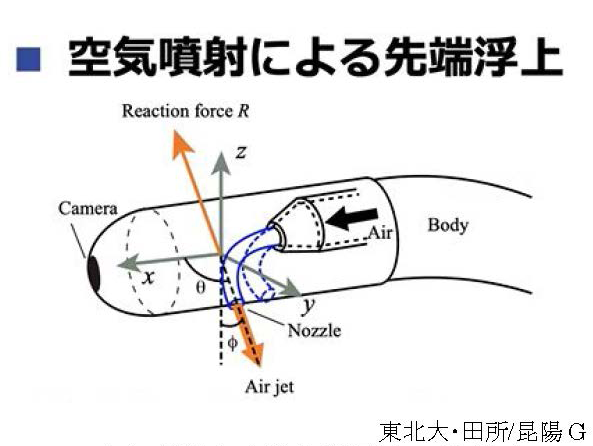

空気と水を噴射させて“能動スコープカメラ”の運動能力を向上させる

ImPACTタフ・ロボティクスチャレンジでは、この能動スコープカメラの運動能力をもっと高めること、それから「見る・聞く・触れる」というセンシングの能力を向上させること、そのようなインテリジェンスの研究を行いました。中心となったのは私と東北大の昆明雅司先生です。

動く(=運動能力)という点では、図のように空気を噴射することによって蛇型のロボットが宙を浮いて瓦礫の中を動いていくという技術を開発しました。これまでの能動スコープカメラでは瓦礫のような場所では全く動くことができず手も足も出ないという状況だったのですが、この技術によって瓦礫の中をある程度動き回って中の映像を撮る等の作業が可能になりました。

この空気噴射によって得られたモビリティ機能を使って瓦礫の内部を調べる作業をやりました。当時の具体的なミッションは被災者の発見でした。

瓦礫の中の画像を自動認識して、中に何があるかをオペレータに対するガイダンスとして与えることによって、オペレータがより操縦しやすくなるシステムをつくりました。また、被災者を発見する大きな手がかりとなるのが音声なのですが、ノイズに掻き消されないように音声を聴き分けて、それを強調するようなシステムの開発に取り組みました。

瓦礫の中に能動スコープカメラを入れると、画像は撮影してくれるのですが、能動スコープがどこに入っていったのか分からない、その画像はどこを映しているのか分からない、つまり画像がどんどん送られてきても内部の状態がわからない、という問題が生じてきます。瓦礫内部の地図を作成しないといけないわけです。これをSLAMという技術を使って開発しました。SLAMは普通のオフィス空間用としては既に確立された地図づくりの技術ですが、こういった狭い空間ではうまくいきません。そこで高速のカメラを使うとか、フレームの選択を適応的にするとか、そういった技術を開発することによって狭いところでの地図づくりを可能にしました。

この能動スコープカメラは全身を振動させることができます。物に接触しますと振動の波形が変わりますので、それを活用することによって、どこが接触しているかを検出しようというのがこの研究の肝です。これにより、能動スコープカメラの接触状況をユーザーインターフェースで見ながら、カメラを遠隔操作していくということが可能になりました。

これらの研究成果を使って自動挿入システムを開発し、ロボットが自動的に瓦礫の中を調べる技術とシステムを研究しました。これはまさに索状ロボットの自律化、自動化、AI化の研究でありました。

しかし、実際に現場で使おうすると、こういった技術テンコ盛り製品は使い物にならないのです。従って、もっと簡便なものを目指しました。上図のような隊員の方が実際に現場に持って入れるものつくることを狙って機能をがっさり削ったものを開発しました。これらは実際に地震の際の建物調査に使われました。

この研究にとりかかる前、2016年に熊本地震が起こりました。その際に昔つくった能動スコープカメラを倒壊した建物の中に入れて内部調査をしたのですが、現場の大きな障害物を能動スコープカメラが乗り越えられず、中をくまなく見ることが難しかったのです。建築の専門家から受けたリクエストは、柱の下の構造物がどのように破壊されているか、ずれているか、そういったことを調べて欲しいということでした。しかし性能に限界がありました。それがその時の能動スコープカメラの実力でした。

2018年の西日本の土砂災害の時に、開発したモビリティ機能を初めて適用しました。土砂崩れにより倒壊した2階の木造家屋の中に空気を噴射する技術を使った能動スコープカメラを入れたのです。すると非常に奥深くまで挿入することができ、また、奥深くの映像を撮ることができて、これは役に立ちそうだということがわかりました。本事例は実際の救助案件でも災害調査でもなく、災害で倒壊した家屋を使って試験をさせてもらったものです。その後、実機を用いてユーザー試験等を行いました。

しかしそこにはまだあるべき水準との相当のギャップがあって、確かに昔のファイバースコープと比べると良くなっているのですが、「これではまだ機能が不足している」というのがその時のユーザーの声でした。ですからこれを製品化してもその製品を調達する段階までユーザーに進んでもらえるかというと、どうもそうではありませんでした。

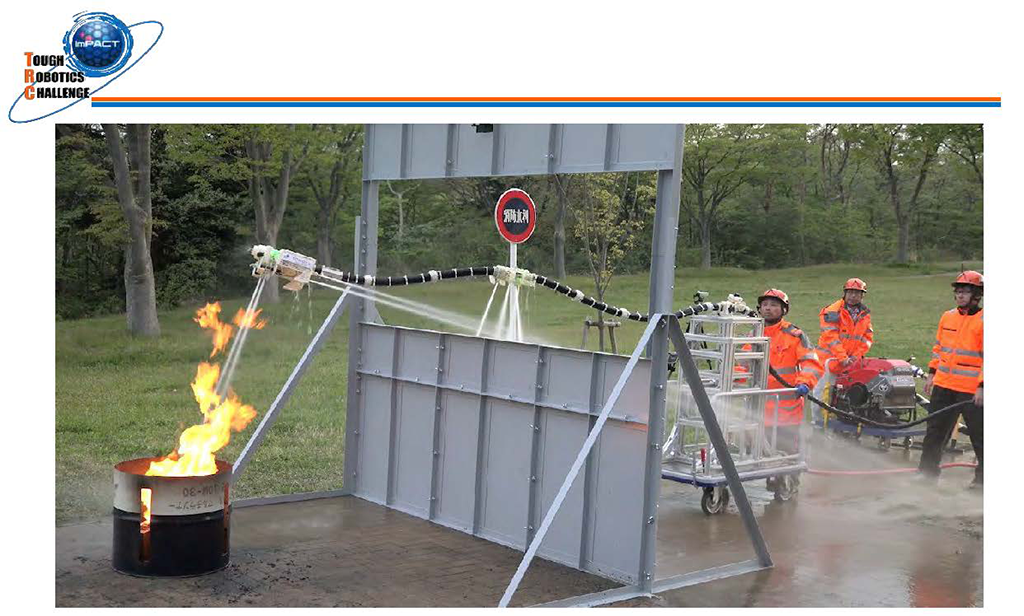

そこで空気に代わって水を噴射する技術を開発しました。水を噴射すると空気噴射の場合よりも重たいものを空中に飛ばすことができます。その原理を使ってドラゴンファイヤーファイターという空飛ぶ消火ホースのロボットをつくりました。

上の写真はその実験の光景です。ホースが浮上して火元を直接消火できるロボットです。あまりホースが長いものをつくれなかったので後ろから人が押しています。このようにホースが空中に浮いて窓から中に侵入して火元を直接消火できる技術を開発しました。

火災の専門家たちといろいろお話をしたのですが、このレベルでは実際に使えるものにはならないという意見が大半でした。まだまだ開発すべき案件が残っている。それが正直な実感です。

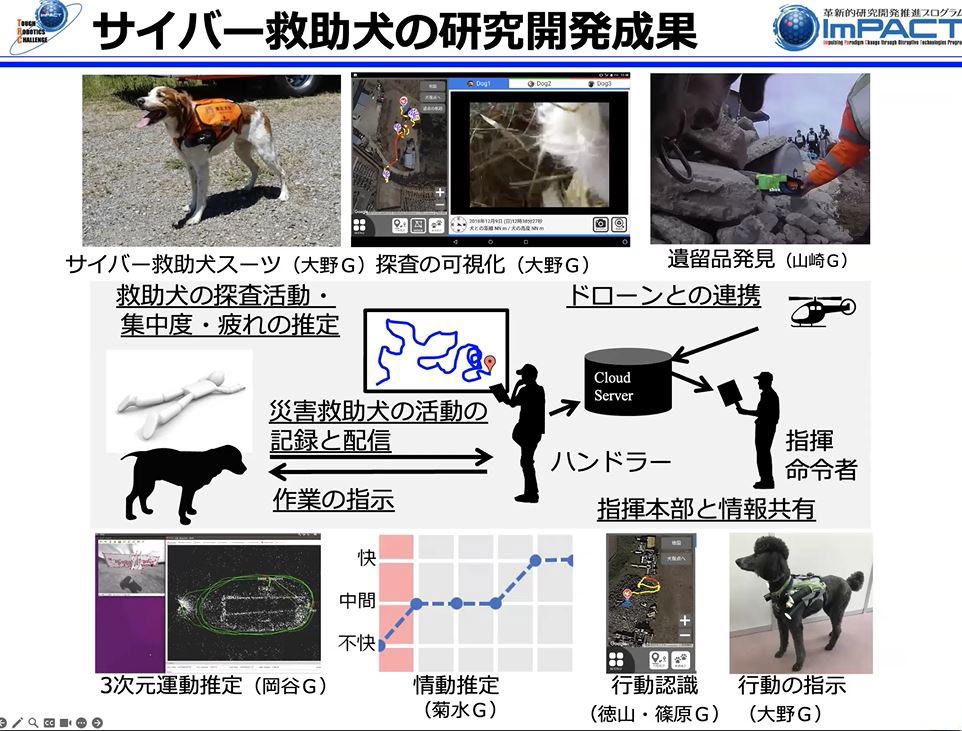

救助犬をDX化する“サイバー救助犬スーツ”

次に紹介するのはImPACTタフ・ロボティクスチャレンジで挑んだサイバー救助犬スーツの研究です。東北大学の大野和則先生が中心となって、日本救助犬協会と協力をしながら犬に着せるロボットスーツを開発しました。

災害現場において救助犬が活動して、要救助者を探し出すわけですが、これを高度化しようというものです。犬は動物なのでどうしても使いにくいところがありますが、サイバー救助犬スーツを着せることによってもっと使いやすいものにしていこうという研究です。

犬がどのくらい集中しているか、疲れているかを推定する。あるいは犬がどこに走っていったのか、なぜ吠えたのかを調べる。あるいは犬に対してどう行動指示するのか。そのような課題の研究を行いました。

犬が見た画像から遺留品を自動認識して、その映像をリモートで携帯電話に送ることによって判別可能にするという実証実験も行いました。

犬がどのように走っているか。どこで吠えたか。そういったことを地図上で全てモニタリングして、犬を有効活用する実験を行いました。これまではハンドラーと呼ばれる犬の飼い主(オペレータ)が犬に完全に寄り添っていないと捜索のミッションを果たすことができませんでした。しかし、このシステムにより、犬を数キロ先まで放って活動をすることができるようになりました。

また、犬による探査活動において、犬の活性度をリアルタイムにグラフで示すことができるようになりました。犬が要救助者を発見した際にエキサイトすると、このグラフでそれを読み取ることができます。こういったデータを頼りにして、犬をうまく操りながら動かしていくという技術をつくり上げていったのです。

さらに犬を誘導する実験を行いました。犬には光を追う性質があります。その性質を訓練した上で、犬を光で操縦して、右に行け、左に行けという指示を出し、所望の場所まで犬を誘導していくという技術の開発をしました。

災害現場におけるドローン活用方法

次はドローンの事例です。

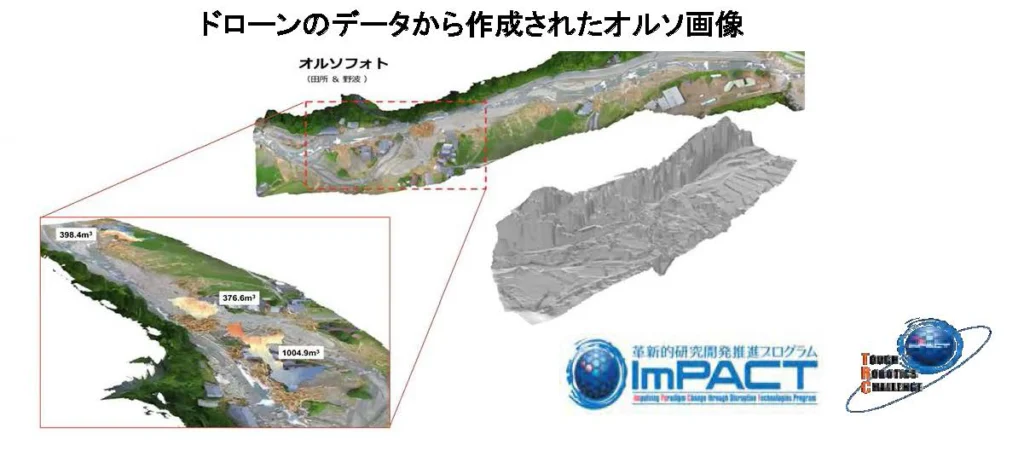

ACSLと共にImPACTの研究に取り組みました。2017年に九州北部豪雨災害が起きました際に福岡県の東峰村の現地に災害出動し、ドローンを自律で飛ばして周辺の地図を作るという活動を行いました。

ドローンで2キロ余りの距離を往復してデータを取り、オルソ画像を作ることがでました。

このようなオルソ画像のデータが取れると、例えばストラクチャー・フロム・モーションという処理で、3次元の地図ができます。また、そこから瓦礫を抽出したり、瓦礫の体積を推定したりできます。そしてこの現場の復旧工事を行うためにどのくらいの土砂を運ばなければいけないかが分かります。そうするとどのようなダンプを何台手配すればよいか判断できます。

そういう意味で、こういった情報収集の手段が非常に有用であることが再認識されて、その後の消防庁のドローン調達等につながっていきました。

ただ、いざ現場に行くと問題山積です。捜索する現場の飛行ルートを指定しようとした時に、現場で携帯が通じなくて地図がダウンロードできなかったという体たらくもありました。地図の上で飛行ルートを指定しようとすると、結構手間がかかるのです。そんなに簡単にはいかない。高圧線、山の起伏、大きな木等いろいろな障害物があります。これらを全てクリアしないといけないのです。それに加えて、ドローンが目視外飛行となるので、有人ヘリとの干渉なども大きな問題となります。救助活動をしている有人ヘリとドローンが衝突してはいけないわけです。そういうことが原因となって、2024年1月に起こった能登半島地震ではドローンの飛行禁止のお達しが出たという話も聞いています。

このようにドローンを現場で使うのはなかなか難しいわけです。

多様な成果が上がりましたが、同時に課題も山積でした。その課題をよく見てみると、技術的な課題もありますが、技術的でない課題も沢山あります。技術的でない課題の中には、実はある技術を適用することで解決ができるものも沢山あります。現場にドローンを配備する場合には、これらを面的に解決しないといけないのです。しかし、ドローン・メーカーは良いドローンをつくることは頑張るのですが、なかなかこういった面的な課題解決が図れません。

そう考えると、ドローンそのものの開発だけではなく、ユーザーが求める機能を発揮できるようにドローン利用の周辺にある条件をきちんと面的に整備をしていく研究開発が重要であることがわかります。ロボット本体が技術的に問題であることも無きにしもあらずですが、そこを解決しただけでは問題は終わらないでしょう。災害救助の当事者にとってドローンもロボットもそのためのツールの一つにしか過ぎない。ですからシステム全体をどのように設計して、どのように整えるかを考えなければいけません。ロボットやドローンの実装が進まないのは、個々のロボットやドローンに問題があるということで片付けられてしまっているが、実はそうではありません。周辺環境を含めたシステム全体のコントロールこそが技術の本質であって、そこを解いていかないといけないのです。フィジカル・インテリジェンスとは、そういったところまで踏み込んで現場とロボットの頭の中とを橋渡しをしていく知能です。

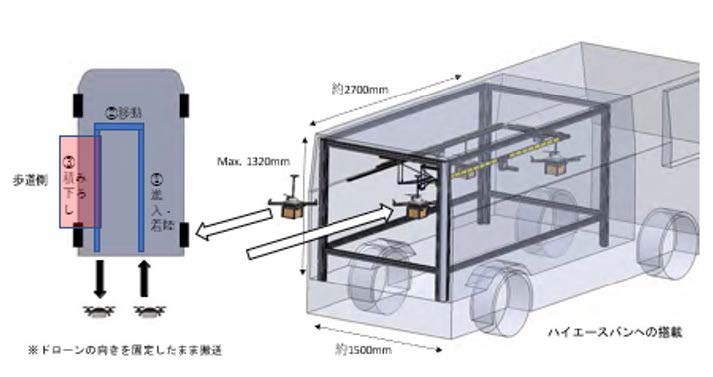

新しいスタイルの社会インフラ “EAGLES Port”

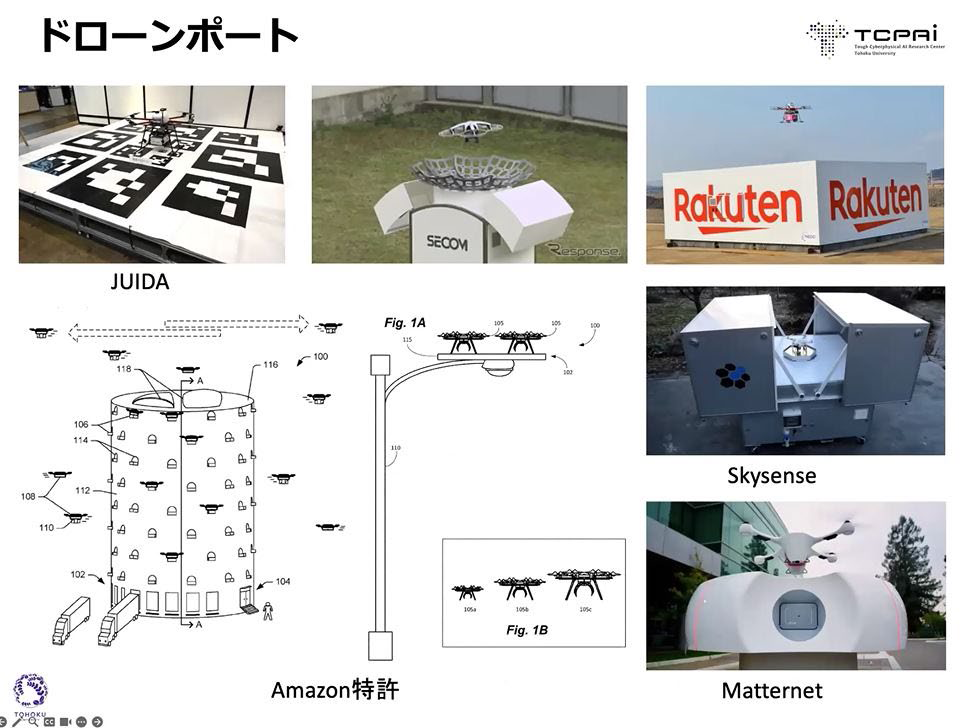

ドローンがフィジカル・インテリジェンスを実現するためのインフラとして新たなスタイルのドローンポートを開発しました。

ドローンポートはご承知の通り、上図のようにドローンが離陸着陸できるものです。

この左側のアマゾンの特許のような状態を実現しようとすると、著しく沢山の離発着ポートが必要になり、現実の運用上は大問題になります。

東京オリンピックの開会式で披露されたようなドローンショーをやることを想像してみてください。一千機のドローンを平地のグランドの上に並べておいて、それを一斉に飛ばさなければなりません。いったいどこの倉庫でそんなことができるのか。一千機をどうやって飛ばせばいいか.。そう考えるとお寒い感じがします。

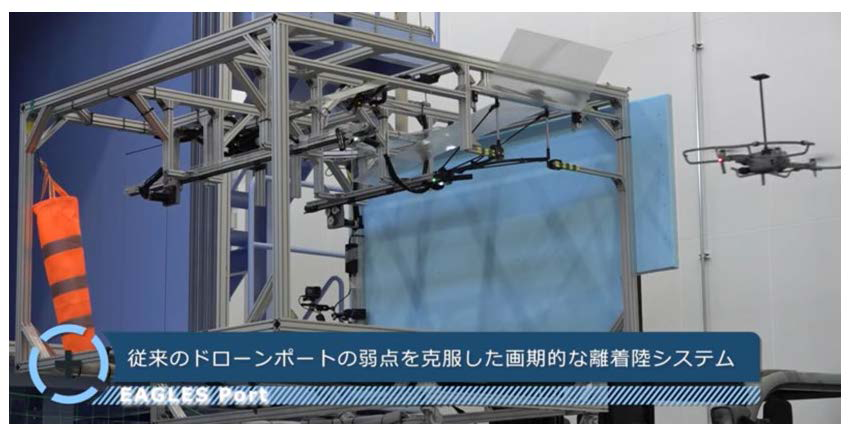

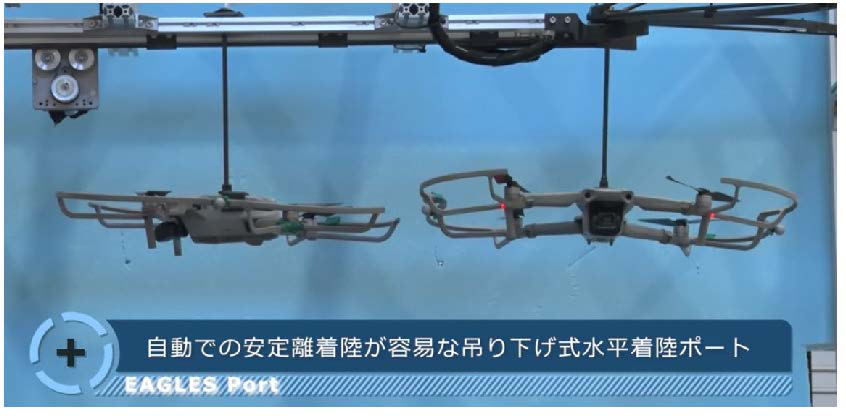

そこで、EAGLES PORTという技術を開発しました。次の写真をご覧ください。

*次の写真は(https://youtu.be/juoE1EX16pQ?t=4)からの抜粋

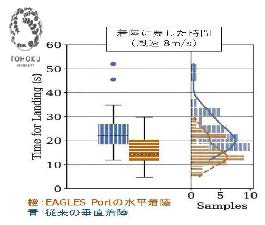

EAGLES Portがもたらすドローンの社会実装の可能性の深化と拡大

先程、周辺環境を含めたシステム全体のコントロールこそが技術の本質だと申しましたがEAGLES Portはその思想に即したアプローチです。

EAGLES Portは写真でお分かりの通り、吊り下げ式の水平着陸ポートです。この技術はAIを搭載したドローン、つまり自律知能を有するドローンの社会実装を進める上で大きな役割を果たすはずです。EAGLES Portは、従来のドローンポートの弱点を克服した画期的な離着陸システムであるのですが、具体的には以下の特長を有しています。

特長1:高い安定性と耐風性能

従来方式のポート、垂直に着陸するため飛行安定マージンが低く、風の影響が大きく受ける。そのため着陸位置精度が低い。EAGLES Portは、安定マージンが高い水平飛行状態を保ったまま高速での着陸が可能になります。その結果、風にも強く、着陸の精度が高くなります。

風速3メートルの場合、従来方式のポートでも着陸できましたが、EAGLES Portでは着陸が短時間で済みます。風速が6メートルの場合、EAGLES Portはやはり短時間で着陸しますが、従来方式ポートでは、着陸精度が不安定でかつ時間がかかります。風速を9メートルに上げて比較運転すると、EAGLES Portでは普通に着陸できましたが、従来方式のポートでは着陸が困難になりました。

特長2:水平飛行は軌道精度が高いので自動化が容易

従来方式では、オペレータが操縦して決められた水平面に着地させなければならなったためオペレータの操縦スキルによって飛行軌道や離着陸の精度が大きくバラつきました。なによりも一台のドローンにスキルを有する一人のオペレータを貼り付けるのですからドローンを活用すると高コストになります。これがドローン活用のボトルネックになってきました。

EAGLES Portを使うことによって水平飛行での離着陸ができるようになります。そして水平飛行は軌道精度が高いために自動化が可能になります。そうなるとドローン運用のコストが下がりボトルネックが解消に向かいます。

特長3:荷物の積み下ろしが容易

従来は平面上に着陸するため、運搬荷物の受け渡し、バッテリー交換、メインテナンスに手間がかかりました。吊り下げ方式によりドローンの下側が空くため、荷物の受け渡し、バッテリー交換、メインテナンスが容易になります。

特長4:複数ドローンが連続着陸できる

1カ所で多数機が着陸でき、かつ高速での連続着陸も可能になります。またEAGLES Portでは、航空機の滑走路と同じ方式で、着陸を誘導できます。

特長5:車に搭載して運搬できる

サイズはコンパクトにつくることができるのでワゴン車の荷台などに載せて運ぶことができます。これにより、現地到着後に、車両から直接離着陸できます。例えば山間部でドローンによる点検をする場合、人がアクセス困難な場所にドローンの離発着の基地を設けてやって自動で定期的に点検をすることが可能になります。基地を移動できることによりアクセス困難な場所でもドローンのオペレーションが容易になります。

特長6:1つのポートに様々な種類のドローンが離着陸可能

EAGLES Portには種類を問わず様々なドローンを離着陸させることができます。一つのEAGLES Portを設ければ、メーカーを問わず、様々ドローンが運用可能になります。

以上、EAGLES Portの特長を述べてきましたが、いくつか補足を述べます。

福島ロボットテストフィールドの風洞棟を使って強風下での着陸試験で極めて顕著な結果が出ました。着陸所用時間を35%短縮することができ、着陸位置の位置精度が大幅に向上したのです。1箇所に多数のドローンが連続着陸できることも実証されて、大きな有効性が示されました。

実は今回の実証実験では、ドローンをEAGLES PORTに手動で着陸をさせたので、オペレータがどのくらい慣れているかによってドローンの着陸の精度に大きな違いが出てしまいました。手動離着陸では、このEAGLES PORTの威力が必ずしも顕著に現れてこないのですが、自動離着陸を前提とすると、狭いところに自分でどんどん着陸をし、自分でどんどん離陸をしていくことが可能です。そういう意味でかなり筋が良い技術になるはずです。

EAGLES Portの意義1-フィジカル・インテリジェンスの実現

現在のAIを搭載したロボットは、結局のところ、人工的に作り上げられた空間の中でだけ自律機能を発揮できる水準にとどまります。物理的に困難な環境条件下では殆ど機能しないのです。そのブレークスルーをロボット単体に求めることには限界があります。困難な環境条件下でもそれに適応してタフに働くためにはどうすればいいか。人間を含む複数の知能体が相互に繋がって実現する集団知能、つまりフィジカル・インテリジェンスにその解があります。EAGLES Portは航空機の滑走路と同じ方式で着陸を誘導できる知能体であり、AIを搭載したドローンとつながりドローンと共に集団知能を形成します。

周辺環境を含めたシステム全体のコントロールこそが技術の本質であって、そこを解いていかないといけないのではないかと申し上げましたが、EAGLES Portが集団知能の一翼を担うことでフィジカル・インテリジェンスを実現し、周辺環境を含めたドローン運航システム全体へのコントロールを強めることができる。それがEAGLES Portの意義だと思います。

EAGLES Portの意義2-ロボット・コンシャスな社会づくり

EAGLES Portのもう一つの意義を語ります。それはロボットコンシャスな社会づくりへの寄与です。今後ますますロボットが人間と共生していく状況を考えた時に、AIを実装したロボットコンシャスな社会や産業基盤をつくっていく必要があります。

EAGLES Portが小型ドローンのための離発着ポートの共通方式となり、メーカーを問わず利用できるようになるとドローンの実用範囲が大きく拡がります。EAGLES Port自体もかなりの自由度で移動できますのでドローンが社会の隅々まで、あるいは険しい自然、気候条件の土地まで入り込むことができます。しかもドローンの自動化をはかることでその効率は飛躍的に向上します。

災害現場付近に車載EAGLES Portが到着。そこにメーカーが違う様々なドローンがどんどん集結して着陸。そして100台を超えるドローンが災害状況を把握するために一斉に飛び立つという光景を見る日が近いかもしれません。車載EAGLES Portがこのようなロボットコンシャスな社会基盤として実装されていくことで災害対策も進化します。EAGLES Portが離着陸ポートの世界共通のインフラとして活用されるのであれば世界は大きく変わるでしょう。

コンテストがロボットを発展させる-”WRS ワールド・ロボット・サミット”の開催

私たちはワールド・ロボット・サミットを開催してきました。OECDの閣僚理事会での安倍首相の発言がきっかけとなって始まったものです。ロボットのコンテストを活用することによってロボットの適用を広めることを意図しています。

ロボットのコンテストというとNHKの番組でやっているロボコンのイメージが大きくて、なんだロボコンかと思われがちなのですが、実のところこれがオープン・イノベーションのための方法論としてコンテストは極めて有効であることが世界的に知られています。

オープン・イノベーションの事例としてDARPA (米国防総省高等研究計画局)の主催によるグランド・チャレンジとアーバン・チャレンジがあります。前者は砂漠、後者は都市の中を自動走行する自動車のレースです。これをやることによって、技術的な開発もさることながら、多くの人々が自動走行を目の当たりにしてその可能性を信じるようになりました。これが大きいのです。

そういった意識改革を行うことによって、自動車の自動運転の道が開かれました。ここで意識改革した人的資源がベースとなって現在の自動運転の時代ができ上がってきたのです。Googleカーもこの流れの中で走り始めました。

また、ロボカップ・レスキューという競技会がベースとなって、先にご紹介しました原発で活躍したQuinceの基盤が出来ましたし、また、AUVSIという団体がやっているコンペティションがベースとなって、現在の自律ドローンの基盤が築かれてきました。

ロボカップのサッカーでは、当初はソニーのAIBOが使われていましたが、AIBOの販売終了があり、2007年に主催者はアルデバランというベンチャー企業からNaoというロボットを標準プラットフォームとして購入することを決めました。その結果として、アルデバランは自律機能を持つロボットの開発をどんどん進めることができるようになりました。その後、アルデバランはソフトバンクに買収されて、それが今のペッパーに繋がっていったのです。

そんなふうにして、コンテストは市場が未成熟の段階から意識改革を促し、人的基盤を形成し、新たな研究開発へと向かう潮流をつくり上げて、大きな実績を上げてきています。

ワールド・ロボット・サミットにおいてオープン・イノベーションを推進する場として、「プラント災害予防チャレンジ」という競技を実施してきました。

ワールド・ロボット・サミットは2018年にプレ大会を行い、2021年に本大会を行い、また、2025年には第2回のワールド・ロボット・サミットを実施します。

P1~P5までのタスクが設定されています。ロボットがそのタスクのクリアを競い合う競技です。

タスクP1: プラントの中の日常点検と設備の調整。配管に設置されているメーターを見ながらロボットがバルブの調整。

タスクP2: 異常検知と緊急対応。酸素濃度異常を示しているタンクの中にドローンがセンサー・プローブを挿入して、中の状態を測定。また、地上走行ロボットが設備にプローブを当てて、異音や振動を検知。

タスクP3: パイプ群とダクトの設備診断。ダクトのボルトの緩みや錆などを調査。

タスクP4: タンクの設備診断。タンクに貼ったクラックとか錆のサンプルプレートの検査。

タスクP5: 総合試験。今までのタスクの組み合わせと同時に、緊急事故が起きたという想定で救助を求めている人を捜索。小型ロボットが障害物のパイプをどけて、向こう側を捜索して、どこに人がいるかを調べる競技。

以上が2021年の内容ですが、2025年はこの競技を継続していこうと考えています。

主催が福島国際研究機構に変わりましたので災害時を念頭に困難な環境をメイン・ターゲットにして競技を実施します。ベースはプラントの点検や設備診断にありますが、それをより厳しい環境で実現できるようにしようというのが今回の目的です。P1からP6というミッションを掲げまして、緊急対応としてバルブの操作や事故の対応などを取り組もうということになっています。

今回の重要ポイントは、いかにして自律化を果たしていくかということです。自律とは、遠隔から何らかの方法で自動的にミッションが与えられて、そのミッションをクリアするためにロボットが自動的に何らかのタスクを行うはたらきです。また、ロボットが集めた情報が自動的に集約されて、それが災害の対応で、あるいはプラントのメインテナンスに活用され得ることも自律の重要な要件となります。

ロボット側とプラント運営側との間をデジタルツインとしてつなぎ、標準化された通信のミドルウェアを設けて、標準化されたプロトコルでロボットから集めた情報をデジタルツイン側に送って、デジタルツインで何が起きているかをモニタリングできるようにする。また、何をやってほしいかというロボットに対するリクエストをデジタルツインからミドルウェアを通じてロボット側へ送って、ロボットはそれに従ってミッションを果たす。今回の競技でロボットに要求されるのはそういうモデルなのです。

まだこのレベルではインテリジェントとは言えない水準ですが、こういったことを競技会としてやり続けてどんどんレベルを上げていくことによって大きなイノベーションにつなげていく。そしてそれをロボットの社会実装に繋げていくというのが、WRS-ワールド・ロボット・サミット-が展望している未来です。

2.空間エージェント網が切り拓く未来

-フィジカル・インテリジェンスの展開構想ー

(1)困難環境下のインテリジェンスの検討

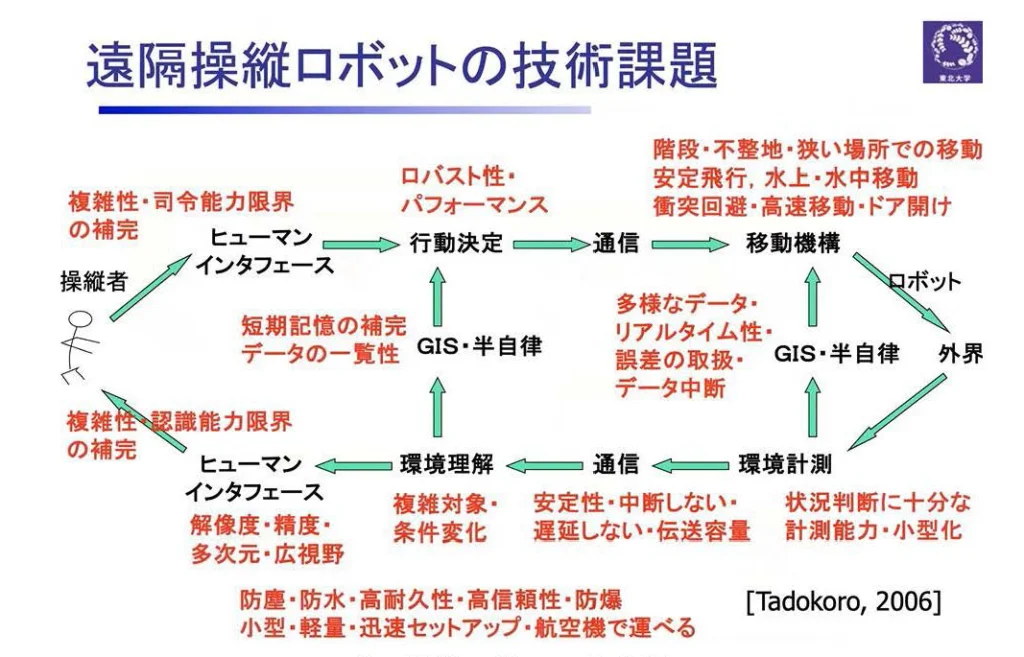

遠隔操縦ロボットのインテリジェンスを実現するループ

次に、このようなインテリジェンスがどのようにして実現されるのかを考えてみます。

Quinceを開発したNEDO(国際研究開発法人・新エネルギー・産業技術総合開発機構)の戦略的先端ロボット要素技術開発プロジェクトでは、地下街の中を走り回って内部を調べるというミッションを検討していました。このような、一見単純なインテリジェンスをどのようにして実現するかを考えたものが以下の図になります。

上図は、ロボットの内部と外部のデータフローを表したものです。

右側にロボットがいます。ロボットはボディを持っていて、移動機能とセンシング機能を持っており、外界に対して働きかけを行い、また、外界の変化を検出します。それを基にしてロボットの作業が計画されると、これが一つの自律機能になるわけです。

このような自律的に動けるロボットが、通信でオペレータ側と繋がれることになります。ここでは、オペレータ側で行動決定をしてロボットに指令する。あるいは、ロボットが収集したセンシングデータをオペレータが理解する。そういうインテリジェントな処理をリモートで行うということが想定されています。

リモートで行われた環境理解の結果がヒューマン・インターフェースを介して操縦者に送られ、操縦者の意図はヒューマン・インターフェースを介してロボットの行動決定に反映される。このような何重にもわたるループが動くことによってインテリジェンスができる。そのような整理をしてQuinceの研究開発が行われました。

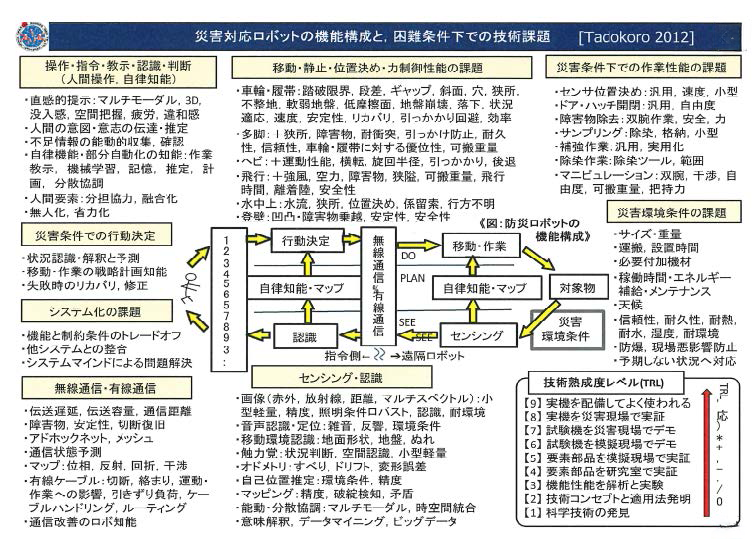

災害対応ロボットの機能構成と困難環境下での技術課題

その後東日本大震災の後で、COCN(Council on Competitive-Nippon 産業競争力懇話会)において60社ほどの企業、政府、研究者の方々に集まっていただき、困難条件下での技術課題は何かを議論しました。

例えば移動の機能一つとってみても、凹凸段差、地盤崩壊、障害物、強風、耐久性等々、様々な事柄が重要な要因になってきます。作業性能、センシング性能、それに加えて、無線性能、そして遠隔操作と自律知能。困難条件下で必要となる要素をまとめました。

この時点での技術課題を挙げたのですが、実はもっともっとインテリジェントにしていかなければならない、というのが現実の要求であります。

困難環境におけるロボットのインテリジェンスのレベル化

困難環境におけるロボットのインテリジェンスというものを整理すると、以下のようなものになります。

- Full Autonomy ロボットが自分で考えて行動

- Adjusted Autonomy 人間の介入レベルを状況に応じて調整

- Supervised Autonomy 人間の管理下で自律行動

- Shared Autonomy 自律機能に人間が介入

- Guided Autonomy 自律機能によるガイドを受けながら遠隔操作

- Assisted Autonomy 自律機能に支援されながら遠隔操作

- Manual Teleoperation 人間が遠隔操作

1で示したFul Autonomyとは、ロボットが自分で考えて自分で行動できるということです。つまり、ロボットが人間と全く同じように行動ができるのです。熟練作業者が現場に行って何をするかを自分で判断して自分で修理を行ったり、点検をしたりする。そういうことを全部できるのがFull Autonomyになります。

それに対して、人間の管理下で実行動を行うのは、1.Supervised Autonomy、あるいは、自律機能に人間が介入する4.Shared Autonomyのレベルになります。

そのレベルを調整できるようにしたものが2.Adjusted Autonomyです。ロボットが自動的に行えるものと人間が介入するものを最適に組みあわせてうまく使い分けながら自律的な機能を果たしていくレベルです。

現場で点検するロボットに対して、どんなことを点検してほしいという指示を人間が与えて、ロボットが現場を動き回って指示事項を調べてくるというのは、典型的な3.Supervised Autonomyであり、あるいは場合によっては4.Shared Autonomyのレベルであるわけです。

5.Guided Autonomyは、自律機能によるガイドを受けながら人間がロボットを遠隔操作するというものです。右に動けと指示するとロボットは自分で動いてくれます。そこは自律なのですが、人間がテレオペレーションしています。

6. Assisted Autonomyは人間がテレオペレーションをするけれども、ある時にある事態に至ると自律機能がはたらく。例えば転倒しそうだから危ないよと教えてくれる。そういった支援があるのが6.のAssisted Autonomyになります。

まずはインテリジェンスのレベルを考えていく必要があります。自律して動き回ることだけを絶対視して考えるべきではありません。ロボットの部分的な機能である認識系、移動系、マニピュレーション、作業系、知能系、協調など、様々な部分で自律的に行えるはたらきが沢山あります。

認識系では、ロボットがセンサー・データを生で送ってくるだけというレベルから、データから解釈してマッピングしたり、理解をしたりして、そこで何が起きているかまで分かるというレベル、要するに、得られた生データと現象との間の対応関係がどうなっているかを考えてくれるレベルになれば、自律性が高く有用です。

運動も同じです。モーターをオン、オフする。スピードを変える。そういうところから始まって、それをさらに上位レベルに上げて、ナビゲーションをしたり、移動の行動計画をつくれたりするレベルまで高めていきます。ロボットに対して「点検してこい」と指示しただけで、このような運動制御が自律的に行われるのであれば、そのロボットはしっかりと働いていると評価していいでしょう。

自律できる機能が全部整わなくても、認識系の能力を果たしてくれて、それが有意義であれば、ぜひその能力を向上させていくべきです。他にも、協調し合う複数台のロボット、IoT、人間とのやり取りができるロボット等いろいろな自律的なはたらきをするロボットがあります。従来の制御機器等とも協力をしながら自律機能を高めていく。そういうアプローチが求められています。

(2)トラディショナルなモデルの検討

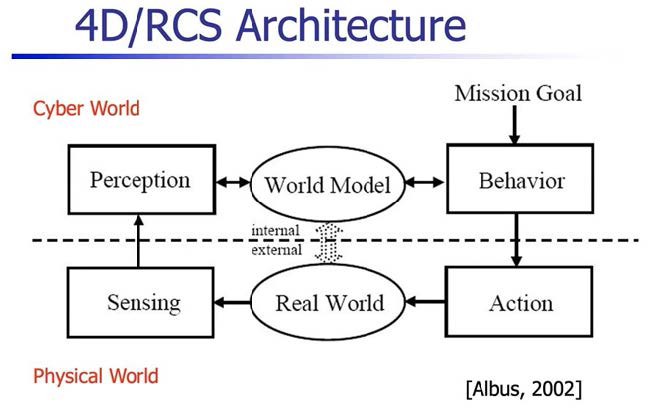

①4D/ROSアーキテクチャのアプローチ

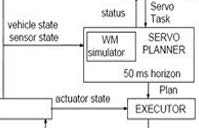

●アルバス氏による4D/RCSアーキテクチュア その1 初期版

ロボットのインテリジェンスをどう整理すればよいのか。トラディショナルには下図の構造がスタンダードなモデルです。

上図はアルバス氏が2002年に発表した、4D/RCS(Four Dimensional Real-time Control System)というアーキテクチャです。点線より上部がサイバーの世界で、下部がフィジカルの世界です。ワールド・モデルとリアル・ワールドの楕円形が中央の上下に配置されています。

様々な形でリアル・ワールドのセンシングがフィジカル・ワールドで行われて、その情報がサイバー・ワールドに伝えられて、それがパーセプションによってシンボライズされて、ワールド・モデルを更新していくというものです。

ロボットには、何をやるべきかというミッションのゴールが与えられていて、このワールド・モデルを使うことによってビヘイビアを生成していく。このビヘイビアをもとにフィジカル空間でミッションに対するアクションを起こし、それがリアル・ワールドにおいて実際に移動したり調査したりといったロボットの行動につながっていく。

サイバー・ワールドとフィジカル・ワールドとをうまく同期させながら、サイバー・ワールドの中でインテリジェントなことを計画し、フィジカル・ワールドでそれを実現していくというのが、この当時の基本的な考え方でした。

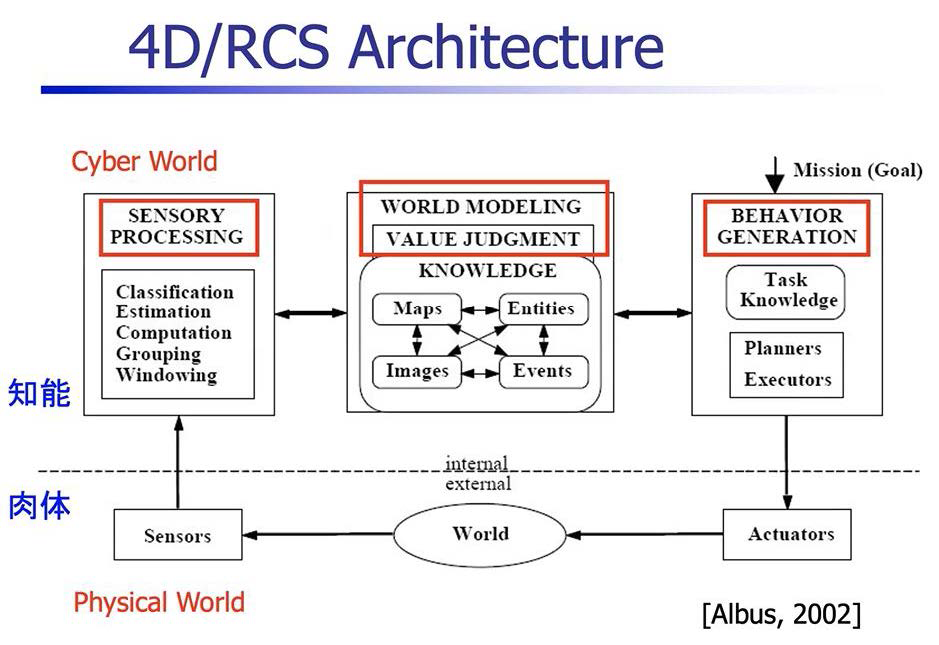

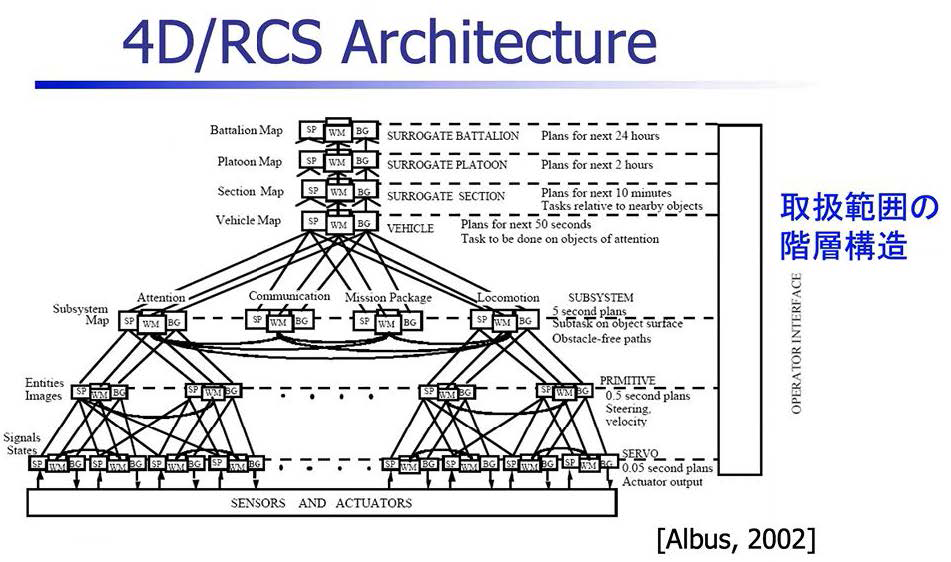

●4D/RCSアーキテクチュア その2 デジタルツインに展開

4D/RCSアーキテクチュアは、米国商務省のNIST(National Institute of Standards and Technology)という機関の研究成果であり、軍事目的の無人車両システムのための参照モデルです。

前掲の初期版の図をもう少し詳しく書いたものが下図です。

サイバー空間の[センサリー・プロセッシング]、[ワールド・モデリング/バリュー・ジャッジメント]、[ビヘイビア・ジェネレーション]。フィジカル・ワールドの[センサー]、[ワールド]、[アクチュエーター]。この図は知能と肉体をツインにして動かしていくデジタルツインのまさに典型的なモデルであります。

もちろんこんな風に単純に行く筈はありませんので、それはアルバス氏もよくわかっています。

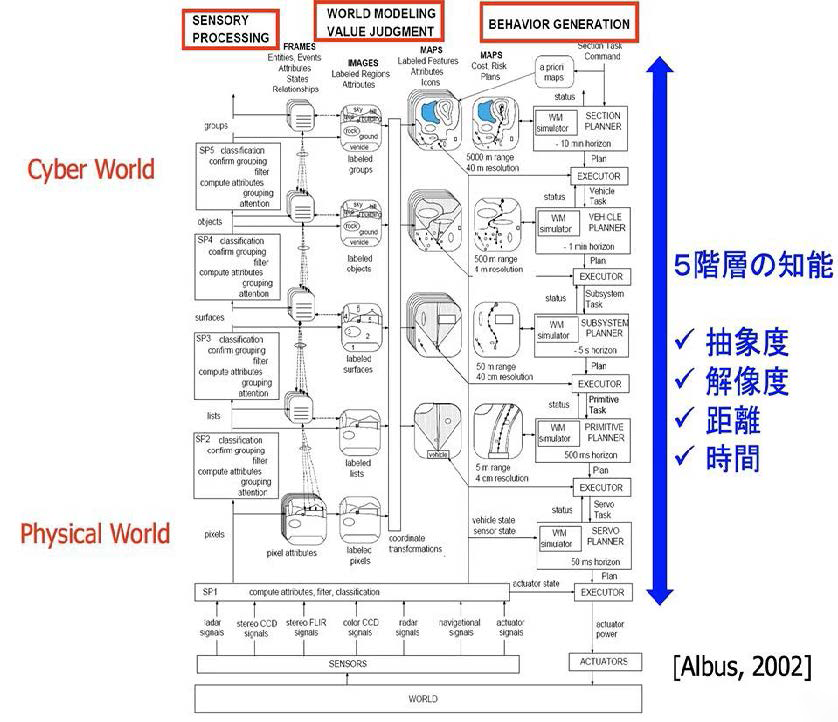

●4D/RCSアーキテクチュア その3 知能の階層化

そこでこれを現実の世界でどんな風に展開していくかを、次頁の図のように知能の部分を階層的に描いています。

フィジカル・ワールドの[センサリー・プロセッシング]⇔[ワールド・モデリング/バリュー・ジャッジメント]⇔[ビヘイビア・ジェネレーション(行動生成)]の相互作用が、フィジカル・ワールドの[センサー]⇔[ワールド]⇔[アクチュエーター]にいたるまでを、抽象度、解像度、距離、時間に応じて5階層の知能のはたらきに展開していきます。

ビヘイビア・ジェネレーションの欄を見ると5階層はこの図では上から、

・Section(分隊)

・Vehicle(車両)

・Subsystem

・Primitive

・Servo

となっており、それぞれの階層で[センサリー・プロセッシング]からのインプットによって更新された[ワールド・モデリング]からシミュレーションして[ビヘイビア・ジェネレーション(行動生成)]―知能を発揮した計画策定-がなされます。

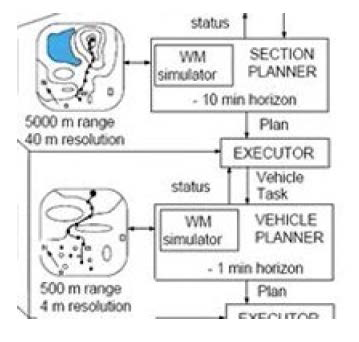

この流れをこの抜粋した図に即して丁寧に見てみましょう。

最上位の階層では、タスクの指令を受けたSection Plannerは、「5000mの範囲」「40m解像度」のマップを参照し、10分先までの行動計画(10 min horizon)を策定。Vehicle(車両)のプランをアウトプットし、それがExecutor(タスク変換モジュール)にインプットされるとExecutorは、Vehicleのタスクをアウトプットし、Vehicleにタスクを指令します。

Vehicle Plannerはそのタスクに基づき、Executor(タスク変換モジュール)に「500mの範囲」「4m解像度」のマップを参照し、1分先までの行動計画(1 min horizon)の行動計画を策定し、Subsystemのプランをアウトプットします。Vehicle Plannerにそのタスクを指令します。

最下位の階層のサーボでは、フィジカル空間において、Servo Plannerに、実際の車両の状態、センサーの状態を入力し、0.05秒(50ミリ秒)先までの計画を立てActuatorをリアルタイム制御するためのプランをExecutorに送ります。Executorは、そのプランのもとActuatorの状態の情報を入力し、アクチュエーターに動作レベルの指令を送ります。

以上のように、上位概念の意思決定からプリミティブなデータ・レベルへ、さらにはボディのモーションレベルに至るまでそれらを階層的に分けることによって知能によるロボット制御を統一的に考えていこうというのが、「アルバス氏による4D/RCSアーキテクチュア その3 知能の階層化」のコンセプトです。

●4D/RCSアーキテクチュア その4 取扱い範囲の階層化

同じような階層の考え方で、取り扱う範囲を階層構造にしたものが下の図です。

サーボ・レベルからプリミティブ・レベル、サブシステムのレベル、それから、Vehicle(車両)、Section(分隊)、プラトーン(小隊)、カンパニー(中隊)、バタリアン(大隊)のレベルまで取り扱う範囲を狭いところから広いところまで階層構造で示しています。

尚、図中のボックスの中にSP、WM、BGという文字が記されています。これはそれぞれ[SP=センサリー・プロセッシング]、[WM=ワールド・モデリング]、[BG=ビヘイビア・ジェネレーション]という略語です。

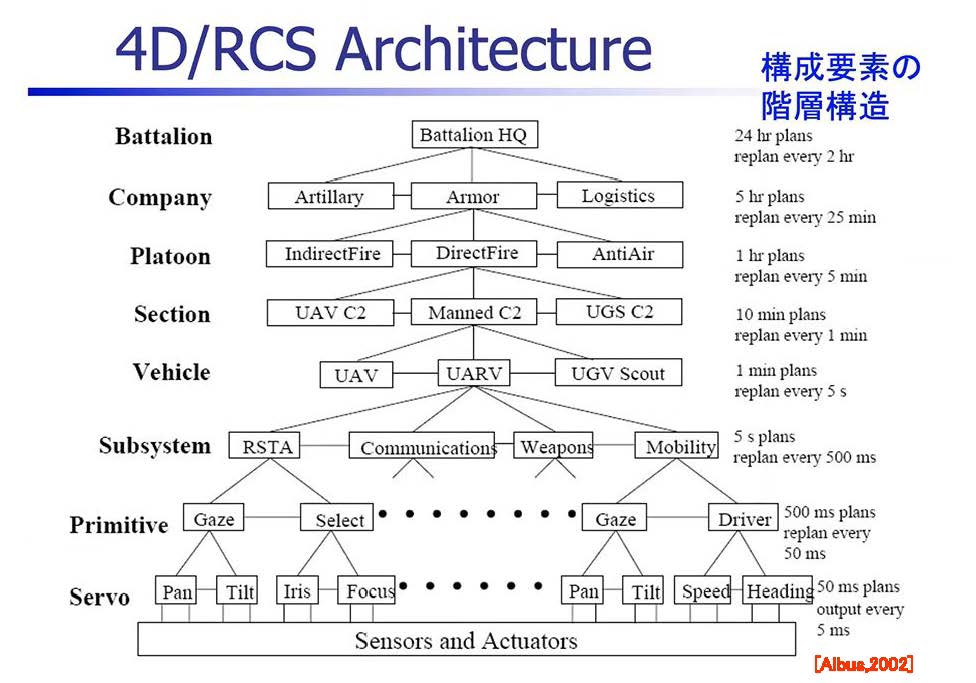

●4D/RCSアーキテクチュア その5 構成要素の階層化

アルバス氏は構成要素の階層構造も考えています。

以下のように、サーボ・レベルから、もっと大きなVehicleのレベル、あるいはカンパニーのレベル、こういうふうなレベルに分けて階層構造を作ることによって、整理して組み立てていこうという考え方です。

それでは上から辿って見てみましょう。

・Battalion(大隊レベル)

Battalion HQ(大隊本部)

→ 24時間先の計画(再計画周期:2時間ごと)

・Company(中隊レベル)

Artillery(砲兵部隊)

Armor(装甲部隊)

Logistics(兵站部隊)

→ 5時間先の計画(再計画周期:25分ごと)

・Platoon(小隊レベル)

Indirect Fire(間接射撃)

Direct Fire(直接射撃)

AntiAir(対空防御)

→ 1時間先の計画(再計画周期:5分ごと)

各小隊の戦術的な動作を決定し、より具体的な指示を出す。

・Section(分隊レベル)

UAV C2(無人航空機指揮)

Manned C2(有人指揮)

UGS C2(地上センサー指揮)

・Vehicle(車両レベル)

UAV(無人航空機)

UARV(無人自律車両)

UGV Scout(無人地上偵察車両)

→ 1分先の計画(再計画周期:5秒ごと)

・Subsystem(サブシステムレベル)

RSTA(偵察・監視・捕捉)

Communications(通信)

Weapons(武器システム)

Mobility(機動性・移動)

→ 5秒先の計画(再計画周期:500ミリ秒ごと)

・Primitive(原始的計画レベル)

Gaze(視線制御)

Select(選択)

Driver(運転制御)

→ 500ミリ秒先の計画(再計画周期:50ミリ秒ごと)

・Servo(サーボ制御レベル)

Pan(パン:左右の回転)

Tilt(チルト:上下の回転)

Iris(アイリス:カメラの絞り)

Focus(フォーカス:焦点調整)

Speed(速度制御)

Heading(方位制御)

→ 50ミリ秒先の計画(出力周期:5ミリ秒ごと)

この構成要素の階層構造をご覧になってわかる通り、4D/RCS(Four Dimensional Real-time Control System)は、極めて中央集権的であり、階層ごとにどんどんタスクを細分化していくアプローチです。Battalion (大隊)からの指令が各層でインプットとアウトプットを繰り返し末端のServo レベルまでくるとカメラの上下、左右の動き、フォーカスまで指示する体系になっています。

このように中央集権的に細部までタスクを割り当てていく指令体系で果たして環境変化や不測事態にシステムが対応できるのか。私たちは当初から疑問を抱いておりましたが、一応これがトラディショナルなモデルですのでご紹介いたしました。

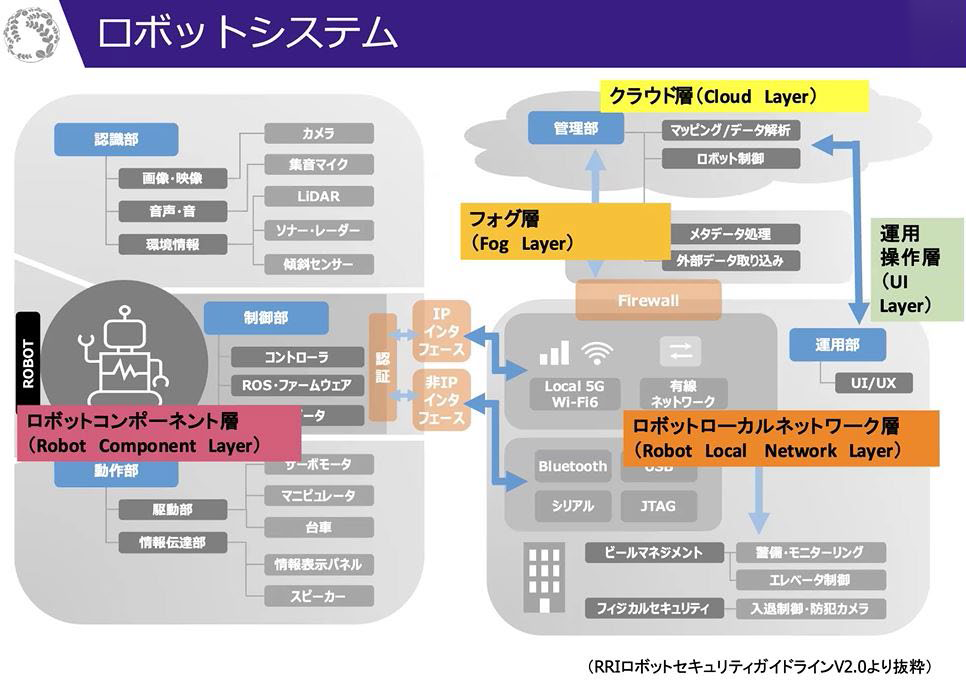

②RRIのロボットシステム

もう一つトラディショナルなモデルを紹介します。

それは下図のようなロボットの典型的な知能構造です。これはRRI(ロボット革命・産業IoTイニシアティブ協議会)が作成したロボット・セキュリティ・ガイドラインの中に出てくる図です。ロボットのコンポーネントは確かにこのようにできあがっているのです。

ロボットは1台ではなく複数台存在し、それがローカル・ネットワークとしてネットワークにつながっている。ネットワーク上にはクラウドがあり、クラウドで処理が行われる。クラウドでは上位レベルの運用の処理がなされてロボットのローカル・ネットワークとの通信が行われる。ローカル・ネットワーク上で下位レベルの細かい処理が行われて、各ロボットにそれを指令し、また、各ロボットがセンシングしたデータがローカル・ネットワークを通じてクラウドにあげられる。そういった構成になっています。

私がこれまでレスキュー・ロボットの技術課題とその困難さを散々語りましたので、今、紹介したトラディショナルなモデルで本当に課題解決が可能なのかという違和感を持つ方もおられるかもしれません。

ですからここからは違う話をしたいと思います。

(3)空間エージェント網で展開するフィジカル・インテリジェンス

FDnetの発想:つながった状態がインテリジェンスになっていく

下の図はFlat Distributed Network アーキテクチャ(以下FDnet) です。日本語では「水平分散アーキテクチャ」と称します。2003年、神戸大学時代に徳田献一氏(現職は農研機構上級研究員)と私がディスカッションをして作成した概念図です。Albus氏の4D/RCSアーキテクチュアが2002年ですのでほぼ同時代のものです。

このFDnetは、センサー、アクチュエーター、意図、環境という4つのアイテムで構成されています。

これは、言語表現の違いはあれども、4D/RCSアーキテクチュアを構成するファクターとほぼ同じであると考えていいでしょう。この図に階層構造を組み入れると複雑なものができ上がるでしょうが、私たちは単純化して一層で描いてこのような概念を構築しました。

続けて下の「スキルの移転」の図を見てください。

ネットワーク・コードで結んで、そのネットワークの発火している部分を意図だと捉えます。そうすると、図の左の意図のパターンを矢印のように右へ持っていけばスキルの移転ができるのではないか。当時はそんなことを考えていました。この考え方は、ニューラル・ネットワークやディープ・ラーニングなどが盛んになった今の時代では受け入れられやすいものだと思います。

しかし結局、構造というものをどのようにつくっていくかという観点からは、4D/RCSアーキテクチュアの階層の考え方とあまり差がないのです。

では何がポイントなのか。

センサー、アクチュエーター、人間の意図、あるいは環境条件。要するに、それらの相互の関係性をどう構築していくのか、それらをどのようにしてロジックで結んでいくのかが勘所です。

それらが繋がった状態が結局はインテリジェンスになっていくのです。

このネットワークにおいては、ロボットが単体であるか、複数であるかは関係ありません。ボディがどこにあるか、その機能がどこにあるか、そういうことはどうでもいいのです。要するにそれが繋がっていて、そこに機能があれば、その機能が地球の反対側で発現されようが問題ではありません。

ネットワークを構成しているものがロボットであるか、IoTであるか、あるいは単にカメラであるか、そんなことはあまり関係がなく、家電であっても構わないし、人間であるかどうかさえも関係ありません。

ネットワーク全体で、その情報が集められるか否か、集められた情報を活用してタフな世界でどのようにしてインテリジェントな機能を発現させることができるか。それが本質的に重要なポイントになります。

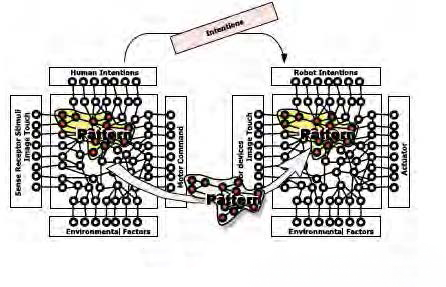

防災のデジタルツイン:サイバー空間のエージェントをフィジカル空間につなぐ

下図はその昔、ロボカップ・レスキュー・コンペティションを立ち上げる際に、知能の構造を考えてみたものです。

サイバー空間にシミュレータを置きました。サイバー空間でエージェント(人間の代理として働くAI)が活動して、どんな活動ができると災害被害を最小限に食い止めることができるかというシミュレーションがこのモデルの基本的な役割です。ここまではサイバー空間の話であります。

これをフィジカル空間と繋ぎますとデジタルツインになって、フィジカル空間で情報を収集することもできますし、フィジカル空間をコントロールすることもできます。

また、人間と繋ぐことによって人間に情報を伝えたり、あるいは訓練をやったり、災害の専門知識を吸収することも可能になります。

サイバー空間の中で、エージェントが持っている知能。あるいはこのモデル自体が持っている理解能力。それらが一つの知能(インテリジェンス)であります。また、フィジカル空間でどのような効果をもたらすことができるのか。あるいはどのようなセンシングできるのか。それらも一つの知能であります。はたまた、人間とどう協力できるか、人間の知能をどう活用できるかというところも、非常に重要な知能であります。

これらを融合させることでいかにして知恵として活用していくかが重要です。そういう意味で、20年以上前に徳田氏と共に発想しつくり上げたFlat-Distributed Network アーキテクチャ (FDnet)は本質をとらえたモデルだったのではないかと確信しています。

フィジカル空間に様々なインテリジェント機能が存在します。これらが連携して単独の知能を超えて集団としての知能ができ上がります。その集団知能をタフにいろいろな仕事ができるように構築していく。イレギュラーな事態にも適切な判断と行動ができるように知恵として鍛え上げていく。フィジカル・インテリジェンスはそういう開発の積み重ねの先に実現していきます。

災害の環境下でユーザーが求めるのは熟練者以上に優れた判断と行動

次に、ユーザー側のことを考えてみます。

ユーザーがロボットに何を求めているか。それは災害の環境下で熟練者以上に優れた判断、行動ができることです。これが実現できないとユーザーがロボットを採用することが難しい。なぜか。災害現場ではロボットと通信が切断される事態が想定されます。その際に、ロボットが自律機能を発揮して一定水準以上の高度な判断で動けないと作業が進まないからです。

「このパイプを切ってもいいんですか?」

そういう問いに解を出すのは簡単ではありません。そのプラントで何が起きているかを踏まえた上で、化学的な反応メカニズムを分かっていないと判断できないのです。一方、それを外から人間が指示しないといけないとなると、通信が切断されている状況下でロボットは何もできなくなります。

プラントのある箇所に異常が発見されたと想定してみましょう。異常のある箇所に行き、そこで詳細な情報を収集し、原因究明し、その上で修理をし、報告をして仕事が完結します。この一連の行動が完結しないとどうなるか。人間がその工程に入り込んで何かをしなければならなくなります。人間が入らないといけないとなると、例えば福島原発のような現場だと結局、対応が迅速には進まなくなります。

ロボットの自律性に求められることは、センシングできるか否かというレベルに留まらず、自分で計画し、問題を発見し、将来を見通せるか否かのレベルまで拡大されています。こういったレベルの知能を考えていく必要があります。バーチャル・シミュレーションの世界では、そのレベルに達するのは難しくないかもしれません。ところがフィジカルの世界になると、人間が助けられない環境にロボットが置かれるシチュエーションを前提にしなければなりません。物理現象はロボットが人間の判断を仰ぐことを待ってくれないのです。待ってくれない物理現象に対してロボットが真摯に向き合って、それをきちんと適切にリアルタイムに処理をしていかなければならない。それができないとなると、自律とは言えないのです。

そう考えると、ロボットの自律化は難しいと言わざるを得ません。しかしながら、ユーザーが求めているのはそういうソリューションであり、フィジカル・インテリジェンスはそのソリューションを果たすことが究極の目的なのです。ユーザーは機材やロボットを求めていません。機材やロボットは必要悪であって、買わなくて済むなら買わない。高価な機械も、高度な技術もいらない。私たちはいつもそんなふうに言われるのです。そう言われても困ってしまうのですが、しかし、その通りと思います。災害空間を自律的に調査するロボットをつくる上で、そもそもロボットを導入するベネフィットは何なのかをしっかりと考えることが必要です。

人間をロボットで代替しようとするなら、人間と同等以上のベネフィットが求められるでしょう。それは必ずしも人間と同等以上の効率で仕事ができるということとは限りません。人間では入れない困難な場所に入れることもベネフィットと認められます。

ロボットの自律性と知能は、目的ではなく手段である。そのことを前提として、フィジカル・インテリジェンスを組み立てていく必要があります。災害空間ではバーチャル環境でのふるまいを生業としているAIは役に立たず、それを大きく超える範疇の機能を求められます。そこをしっかりと考えて手段をつくり出していかないといけないと思います。

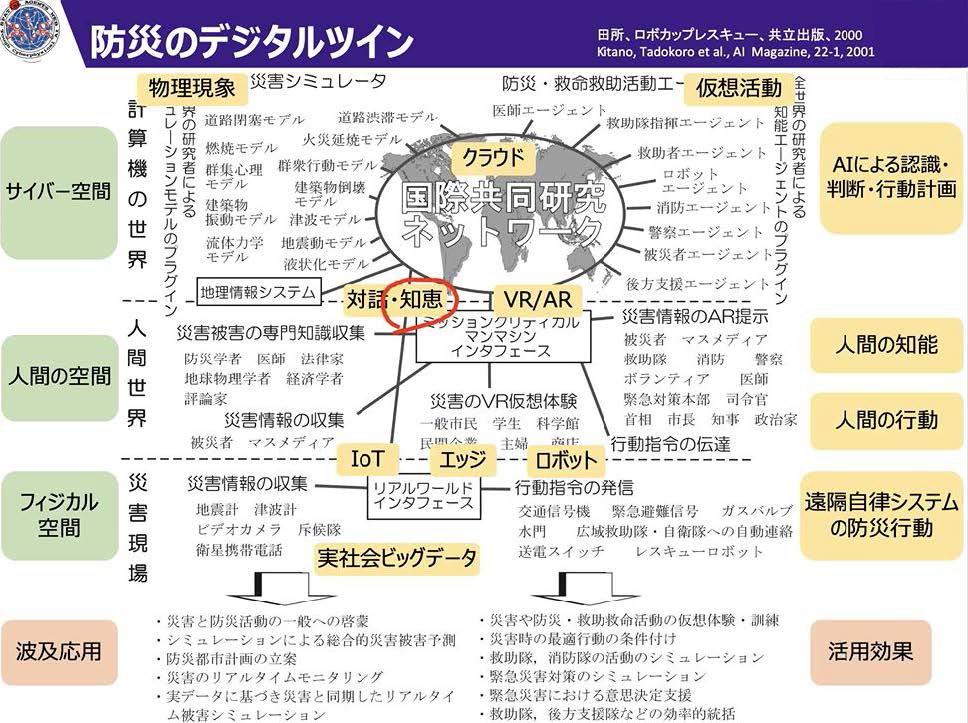

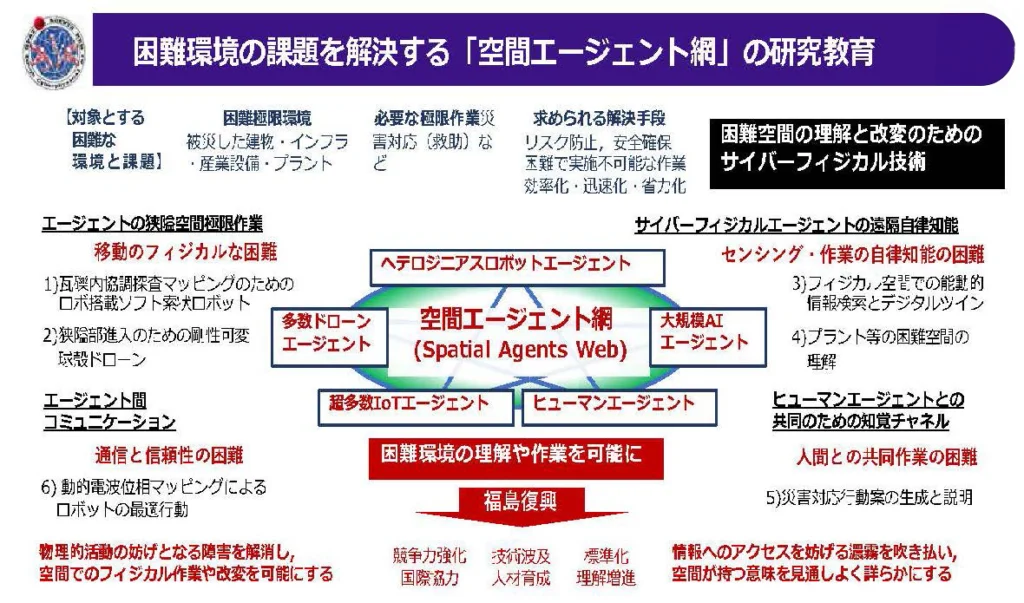

空間エージェント網のコンセプト

フィジカル・インテリジェンスを実現する一つの取り組みとして、“空間エージェント網”を推し進めようとしています。

“空間エージェント網”とは、物理的な空間、機能の空間、組織の空間、そういった様々な空間の中に多様な機能エージェントを配置して、各エージェントがお互いに通信し合い、協力し合うことによって目的を達成しようというものです。この時、エージェントとは、人間の代理として働くAI、あるいは環境や状況の理解に基づいて最適な行動を行う知能体と定義します。

目的は何か。それは困難環境を理解したり、そこで作業をしたり、それが可能なように環境を改変したりしようということです。

空間エージェント網で起こす知能のオープン・イノベーシ

空間エージェント網研究コンソーシアムが組まれて空間エージェント網の構築への挑戦は既に始まっています。東北大学(代表機関)、情報通信研究機構、広島大学、筑波大学、制御システムセキュリティーセンター、大阪大学が参加して福島国際研究教育機構 (F-REI: エフレイ)の委託事業として災害現場など困難環境での活用が見込まれる強靱なロボット・ドローン技術の研究開発に取り組んでいます。

移動のフィジカルの困難の克服、通信の信頼性の困難の克服、センシング作業の自律性の困難の克服、人間との共同作業の困難を克服。このプロジェクトはそのような困難の克服の作業に挑みます。

そして多様なロボット・ドローンが連携し力を合わせて困難環境下で機能を発揮するシステムを構築していくことを目指します。

このような枠組みの中にさまざまなインテリジェンスを放り込んでいって、自由自在にそれらが繋がって協力できるような枠組みをつくることによって、知能のオープン・イノベーションを図ることができて、それがロボットの高度化に留まらず、空間の高度化に繋がっていくのではないかと考えています。

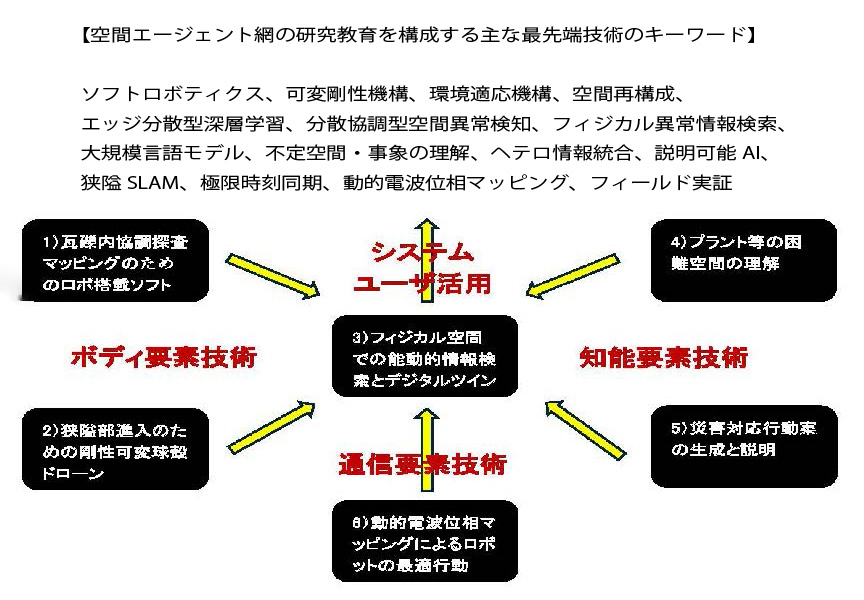

空間エージェント網が向かうべき方向性とオープン・イノベーションのイメージを掴んで頂くために以下の空間エージェント網の研究教育を構成する最先端技術のキーワードとそのシステムへの展開例を下図に示しました。

この下の図からも、空間エージェント網が「人・ロボティクス・デジタルツインの共創」の場であることが、皆様も実感できるものと思います。

空間エージェント網が、これからさらにどんどんヘテロジニアスな知能を取り込みながら増殖し、知のオープン・イノベーションを起こし、困難環境を克服するタフネスを獲得していく。この挑戦をもって私のフィジカル・インテリジェンス(PI)の展開構想としたいと思います。

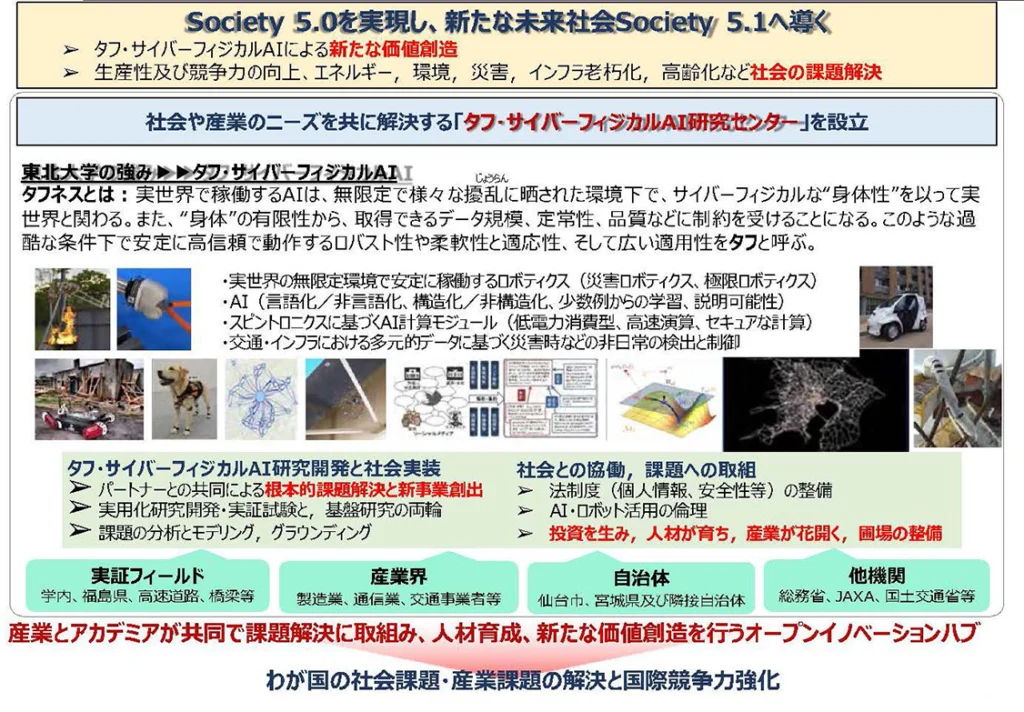

優等生ではなくタフなロボットづくりを目指して

2019年に東北大学タフ・サイバーフィジカル研究センターを発足させて5年経ちました。タフ・サイバーフィジカルという当研究センターが追求するコンセプトはAIロボットが社会課題を解決する役割を果たすための核になるものです。私たちは安定が保障された人工空間の環境下で気の利いた動きができる優等生ロボットではなくタフなロボットをつくりたいのです。ですから以下のようにタフネスを定義しました。

タフネスとは:実世界で稼働するAIは、無限定で様々な擾乱に晒された環境下で、サイバーフィジカルな“身体性”を以て実世界と関わる。また、“身体”の有限性から、取得できるデータ規模、定常性、品質などに制約を受けることになる。このような過酷な条件下で安定に高信頼で動作する柔軟性やロバスト性、そして広い適用性をタフと呼ぶ。

タフなサイバーフィジカルAIを実現したいという目的を共有して集う、フィジカルなロボットの開発者、AIの研究者、高速演算の専門家、サービスの専門家、産業界の研究者と事業開発者、自治体の方々と協力をしながら、さらに多彩な取組を進めていきます。この枠組みを活用して 空間エージェント網を高度化させて、困難環境でのタフネスを実現し、わが国の社会課題・産業課題の解決と国際競争力強化に貢献していく所存です。

Ⅲ.プラントデジタルツイン実現へのシナリオ

千代田化工建設株式会社

参与 フロンティアビジネス本部デジタル担当

井川玄氏

私は元々エンジニアとしてカタールのLNG(液化天然ガス)プラント建設に長年携わり、現地の子会社の社長として沢山のお客様の声を聞かせていただきました。その後、将来へ向けたデジタル技術の検討を進めてきた中で、東北大学の田所先生と先生と志を同じくする方々がプラントでのレスキュー・ロボットの活用を考えていらっしゃるとうかがい、それから今日に至るお付き合いをさせていただいています。

私はプラント業界側からロボットへの期待を込めまして、デジタルツイン実現へのシナリオと題して本日のお話させていただきます。

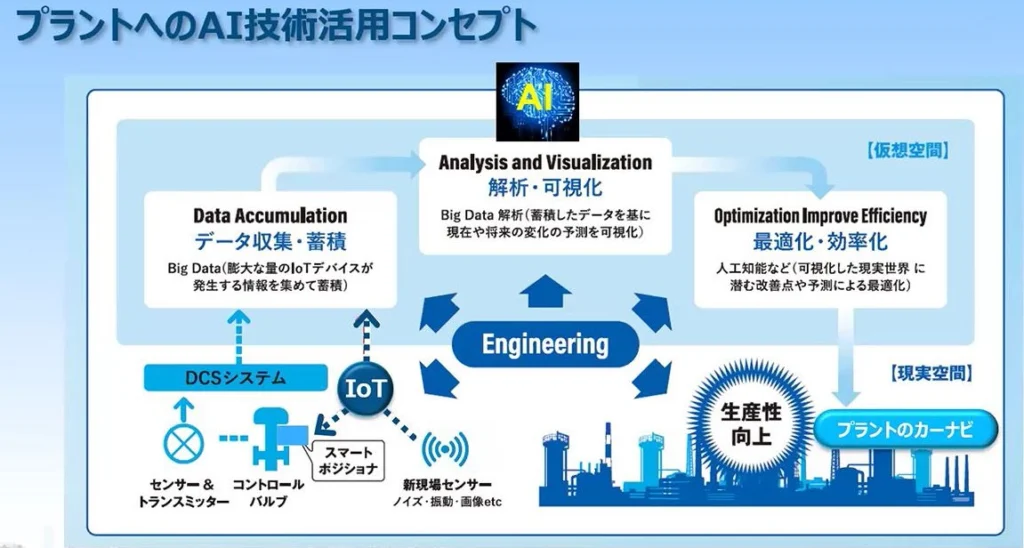

1.エンジニアリング+AI+デジタルで実現するプラントのデジタルツイン

千代田化工建設はこれまで、石油化学・ガス・LNG・医薬・バイオ・非鉄、そして再エネ・水素などのビジネス分野において、エンジニアリング技術を駆使した新規プラント建設や既設プラント改造等のビジネスを展開してきました。

そこで培われたエンジニアリング技術に最新のAI&デジタル技術を融合させ、新たなデジタル・エンジニアリング技術を開発し、新規プラント建設はもとより、既に操業が継続されているプラントへの多大な貢献をもたらすべく、2023年、新たにO&M-Xソリューション事業部を創設しました。

※O&M:Operation and Maintenance

わが社のデジタル・エンジニアリング技術は、既存のエンジニアリング技術に最新のAI&デジタル技術を融合させたものです。その中でも、特に注力しているのがAI技術です。

上図は、運転中のプラントにどのようにAI技術を活用するかを示したものです。図の下半分が現実空間、上半分がコンピュータやネットワーク・サーバーなどの仮想空間を示しています。

2016年にGoogle傘下のDeepMind社がアルファ碁というAIプログラムでトップ囲碁棋士を破ったとのニュースが話題になりました。そこで使われた深層強化学習AI技術がこの図に使われています。これを2017年から組織を新設して推進しています。

プラントのDCSシステムからの運転データは、このData Accumulation部分に蓄積されます。この運転データにエンジニアリングによるノウハウを加えたものをAIに学習をさせることで、状況を予測し、最適化する事が可能になります。

これによって得られた情報は、まずはカーナビのようにAIがオペレータにアドバイスするところから始まって、将来はAIによる自律操業に発展させていきます。

私たちにはお客様のプラント操業中の様々なトラブルに対応してきた歴史があり、長年培った高度解析エンジニアリング技術があります。

そこに最新のAI・デジタル技術を融合することで、例えば、プラントの反応器や加熱炉の内部の状態などを常に仮想的に「見える化」し、複雑な事象の予測や最適化が可能となりました。

これまで、社内では特に海外プラント建設の際に、空間設計の中心として3D CADモデルを活用してきました。3Dモデルを使用した設計のみならず、配管や建築資材の調達管理を3Dモデルとリンクさせており、20年以上の運用実績を積んできました。今後はさらにこの技術を加速させ、3Dモデルを中心とした次世代プロジェクトへ展開していきます。

一方、お客様に対しては、EFEXISというブランド名でのAIデジタル支援を行っています。また、3Dモデルを中心にしたO&M(Operation and Maintenance)デジタル統合を提案しています。

そして最終的には、社内向けとお客様向けの双方の3Dモデルを中心としたデジタル化が、プラントのデジタルツイン構想の下で連携することとなり、これが将来のプラント操業の姿となります。

このプラントのデジタルツインについては、追って具体的に説明させていただきます。

2.AIで実現したプランと業界のソリューション事例

千代田化工建設におけるAIソリューション適用の事例をご紹介します。

本事例は、LNG製造設備の酸性ガス吸収塔におけるフォーミング現象AI予測システムの開発であります。

LNG製造においては、原料中の酸性ガスを十分に除去しておかないと、後工程のプロセスで支障をきたしてしまいます。この酸性ガス吸収塔において、内部で吸収液の泡が急激に大きくなるフォーミング現象が突発的に発生することがあります。これまで、その解決策として、生産量を下げたり、消泡剤の過剰投入をしていました。しかし、それでもしばしばこの現象によって運転停止にいたってしまうことがありました。

そこにAI深層学習を活用し、フォーミング現象発生の予測が可能になり、それによって十分な事前対応を行うことが可能となりました。

この技術は中東地域のプラントにて実際に稼働中です。フォーミング現象によるプラント停止が無くなったとのことで、オペレータの方々からは運転が楽になったとの声をいただきました。

現在、こういったフォーミング現象の予測システムなどのAIを『EFEXIS』というブランド名でラインナップし、お客様へ提供しています。

最近では石油化学プラント向けのみならず、グリーンエネルギー分野、医薬バイオ分野での生産性向上、稼働率改善、保全の高度化等々に寄与するAIシステムを研究開発しています。

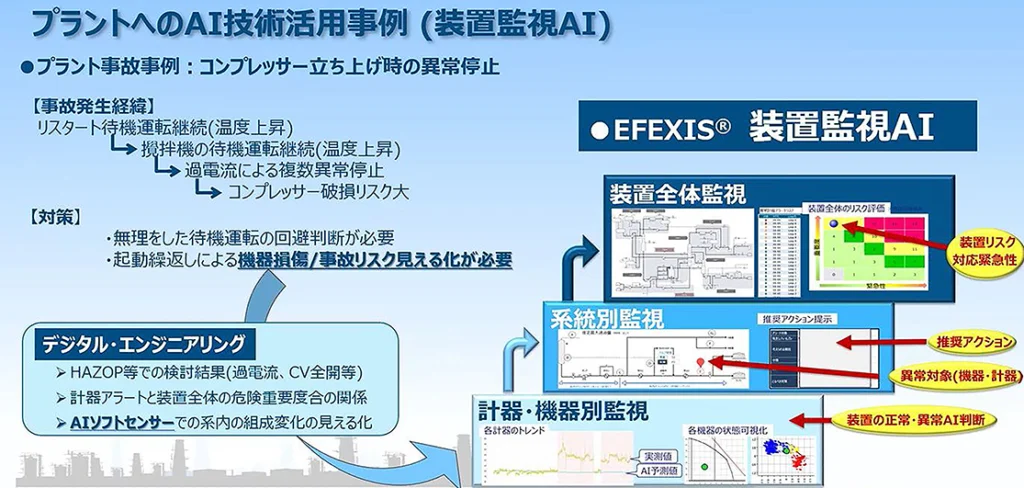

もう一つ千代田化工建設のAIソリューションを紹介します。

プラント業界の過去の事故において、もしこのAI技術を適用していたならば、どのような貢献をもたらせたかという検討事例です。

これは「コンプレッサー立ち上げ時の異常停止」の事例ですが、上図の中の【事故発生経緯】に示しました通り、様々な事象が次々に発生しました。事故調査の結果、今後の対策として、機器損傷や事故リスクの見える化が必要との結論が出ました。

そこで図のように装置監視AIを適用すれば、多角的な観点から、プラントの様々な状態を監視して、安全な状態維持が可能となるものであり、総合的な保安力の向上が実現できます。

3.AIを用いてリアルとシュミレーションの差を埋める方法

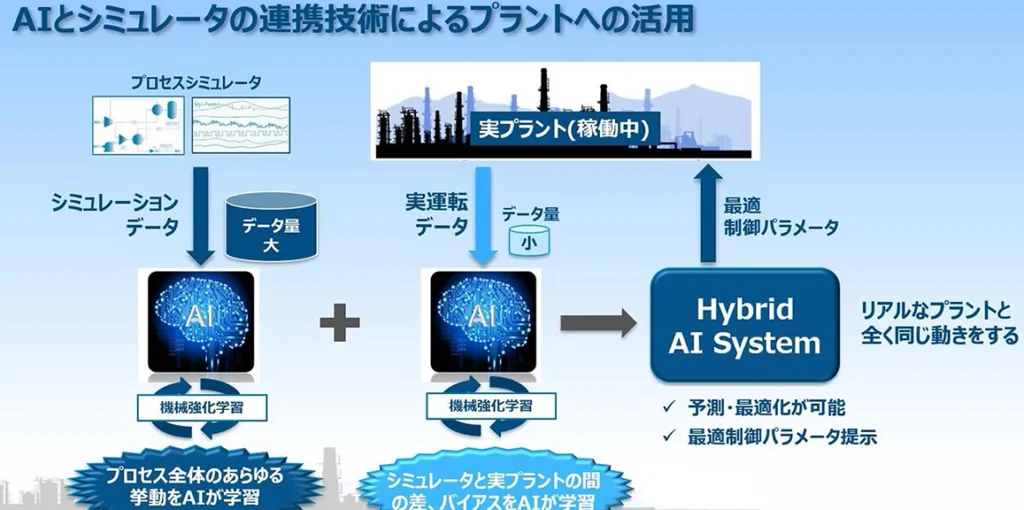

プラントの将来を見据えて、ロボット活用と共に最も重要であると考える技術は、AIとシミュレータの連携技術です。

世の中の一般的なAI学習のやり方は、下図の右側のように、実際の実験データだけを使用してAIの強化学習を行います。一方、左側のように、プロセス・ダイナミクス・シミュレータなどからの計算データを用いることでも、AIの強化学習を行うことができます。プロセス・シミュレータのデータを使用すると、通常運転しない様々な特殊なプラント運転のケースでもAIを強化学習させることが可能となり、不安定な運転を避けるためのアドバイスや危機的状況下の冷静なAI判断が可能になります。そして、この2つを融合させることで、リアルのプラントと全く同じ動きをする仮想プラントをつくる事ができ、それによって予測や最適化が可能になります。

ただし、この2つの方式によるAI学習必要データ量には、大きな差があります。

実際のプラント運転データは、AI学習用としてはデータ量が全く足りません。例えば、異常が発生して災害に到るデータ、製品品質が基準を下回る場合の運転データ等は、実際には滅多に入手できません。一方、プロセス全体の挙動をAIが学習する時には、シミュレータ・データを用いた何十万回、何百万回のAI強化学習が必要です。

しかし現在のシミュレータは、人間がオフラインで数回か、せいぜい何十回か程度使用するケースしか想定されていません。AIと直結して何十万回もの計算を高速なスピードで計算するシミュレータが世の中に無いのです。ですので、千代田化工建設はこれを独自に開発しています。

では、少量しかない実際のプラント運転データは何に使うか。シミュレーションとリアルプラントでの違いの学習、つまり、ポンプや配管、機器のハードに関わる差・バイアスをAIに学習させることに使います。これによって、リアルとシミュレーションの差をAIが常に埋める事ができるようになります。

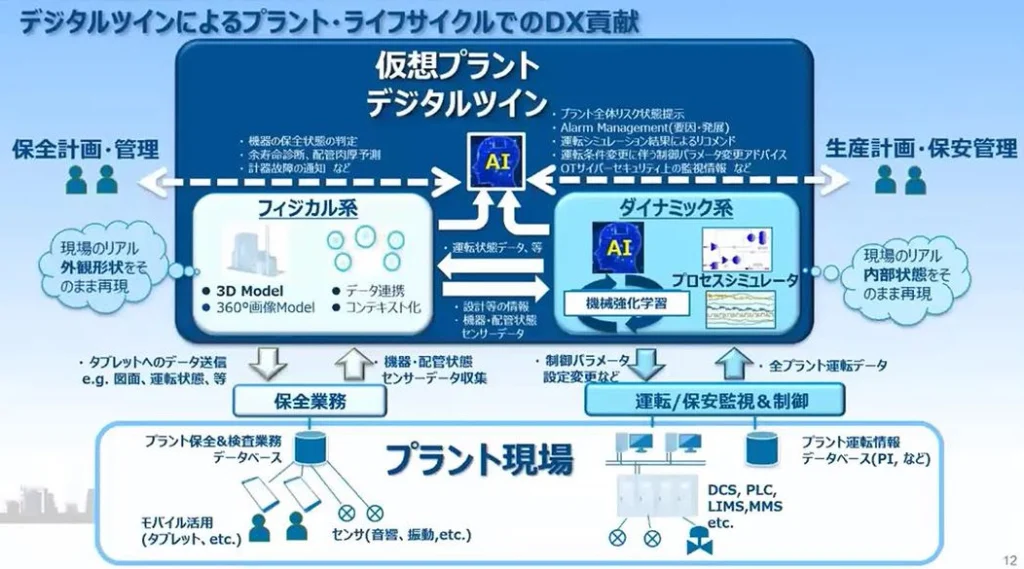

4.仮想プラントデジタルツイン 〜AIを活用してフィジカル系とダイナミック系を融合

次に、3Dを中心にしたO&M(Operation and Maintenance)デジタル統合について説明します。

2018年度に、国内石油会社の協力のもと、NEDO委託事業として、製油所の蒸留塔の周りで3D保安高度化プラットフォームを構築しました。

プラントの数百箇所でレーザスキャンを行って点群データを作り、3D プラントモデルを作成して、この3Dプラントモデル上に、全ての機器・配管・計器番号や検査箇所番号等を明示することで、運転・保全・検査・機器図面などの既存データシステムと全て相互連携することができました。

プラントのデジタルツインとは何か。“ツイン”は文字通り「双子」の意味であり、一人目は現実のプラントそのもの、二人目はコンピュータ上の仮想プラントを指しています。

現実のプラントは3次元構造体ですので、コンピュータ上の仮想プラントも3Dモデルとすることで、両者が一対一に対応可能となるわけです。

仮想プラントには、2つタイプがあると考えています。

- フィジカル系:プラントの外観形状を再現したもの

- ダイナミック・プロセス系:刻々と変化していくプラントの内部プロセス状態を再現したもの

1のフィジカル系は、3D モデルや360°画像モデルで構築し、図面や検査データと連携し、主に保全業務で活用されます。

一方、2のダイナミック・プロセス系は、運転データやシミュレータとAIの連携により、主にプラントの操業運転中の異常予知や最適化へ活用されます。

そして、この2つを融合するさらなるAI活用により、保全計画・管理において、機器の保全状態の判定、余寿命診断などが可能になります。一方、生産計画・保安管理としては、プラント全体でのリスク状態提示や、運転条件アドバイスなどが可能になります。

これらの両方が揃って初めて本当のデジタルツイン、仮想プラントと言えるものになると考えます。

5.ハードからソフト化していく時代 〜テスラとトヨタの違い

次に、ロボットを活用していく時に、コストの観点からプラント業界にどういう効果、変革が起こるのかという大きな流れの説明をします。

テスラとトヨタの車を比べてみます。

操作系の装備を見てみますと、テスラ社の方がシンプルであり、ハンドル・アクセル・ブレーキ以外はタッチパネルに全て集約されています。例えばスイッチやメーターの追加や変更をしたいという要求があった場合には、ソフト更新をするだけで簡単にアップデートできるというメリットがあります。

しかしソフトにも弱点はあります。通信スピードが遅延したりウィルス攻撃を受けやすかったりするのです。それらのRiskとOpportunityをどのように捉えるかというところに、両社の戦略の違いが表れていると考えます。

もしソフトでの弱点が克服されてハードがソフトで代用できるならば、”ハードの設置が最新技術の継続的な導入を阻害する”という根源的な課題を解決できることになります。このことは、プラントでロボットを活用していく中で重要なポイントになりますので、覚えていてください。

6. プラント制御・監視システムにおけるデータ収集&活用の課題

次に、プラント制御・監視システムでのデータ収集と活用における現状課題について説明します。

石油・化学・ガスプラントでは、現場プロセスに数千個のセンサーを配置し、キャビネット室にズラッと居並ぶシステムキャビネットまでケーブルで繋ぎ、中央制御室のボード・オペレータが運転データをディスプレイ上で監視し、コントローラーを調整します。

しかし、この30~40年間のシステム能力開発競争の結果、余りにも多くのデータで溢れてしまい、これが業界全体で抱える大きな課題になってしまっています。プラント業界の景気が好調な時代はオペレータも豊富で、監視制御システムの統合化は高い評価を得ておりました。しかし潮目が変わり、重厚長大になってしまったシステムは人の能力だけでは管理し切れない。既に限界を越えてきています。

ただし、これまで何もしなかったというわけではなく、対策も継続して行われてきました。

膨大な運転情報データに対してはシステム上でプライオリティ化を施したり、膨大な運転アラームに関してはアラームマネージメントが構築されて適用されたりしてきました。しかし、時々刻々と遷り変わるプラント状況下において、データの洪水の中、オペレータ経験者も次々に減っていき、複雑な状況判断が増々困難になってきています。さらに、近年プラントの経年劣化が深刻になっていてリスクが増大する方向ですので、抜本的な変革での課題解決が必要となっています。

7.DXに必要な形式知化 (1)人に見えないもの

ところで、ここでもう一つ、プラント業界のみならず様々な製造業界でデータ化・オンライン化・形式知化が全くなされていない部分がありますので、それを説明します。

それは、現場オペレータ・作業員周りのデータです。

例えば、配管や機器の経年変化を知るべく、現場オペレータの目視チェックが行われます。また、配管やポンプの異常で漏洩・振動・異音などがあった場合には、現場オペレータが五感で気付きます。さらに、現場指示計については、オペレータが巡回する際に指示値を読みます。現場指示計は、リモートセンサーと常に一対一で設置されています。これはどういうことかというと、リモートセンサーの値がおかしい時は現場指示計の値を読み、2つの計測値を比較して、そこに故障の予兆を見つけて対処しているということです。また、中央制御室では知る事の出来ない現場情報として、多数の手動弁開閉の現在の状態がどうなっているかという情報があります。手動弁を操作するのも、やはり現場オペレータの役目であり、その手動弁の開閉具合が硬かったり柔らかかったりした時に、それが以前との状態とどう違うのかを知っているのは、現場オペレータしかいません。

現場オペレータ周りで得られるこれらの情報に関して、「データ化・オンライン化・形式知化」が全くなされていません。このことが、プラント業界や製造産業現場において、完全なる自律運転を目指す上で、今後最も大きな課題となることでしょう。

製造ライン工場において、次世代スマート工場を目指すべく、MES(Manufacturing Execution System日本語では「製造実行システム」)の導入検討が欧州を中心に進んでおり、最近日本でも進められています。このMESを中心とした次世代工場構想においても、現場オペレータ周りの情報に関して全く「データ化・オンライン化・形式知化」されていないことが、今後大きな壁になってくると予想しています。

現在、殆どの方がそんな情報のデータ化は無理だとおっしゃると思いますが、私はそうは思っておりません。本日のテーマである自律走行ロボット、そこに搭載する様々なセンサーは、既に人間の視覚・聴覚・嗅覚を越えています。

上の図は、コニカミノルタ社製の特殊赤外線カメラで可燃性ガスが漏洩する姿を捉えたものです。これは静止画像なのですが、YouTubeにアップロードされたこの漏洩状況の動画をご覧頂くと、このカラフルな色、つまり漏れた可燃性ガスが、ユラユラと漂って流れていく光景が見れます。この状態を、水蒸気や人の動き等の様々な外乱に影響されることなく、約180mの離れた距離から感知できます。また、カメラの信号からノイズを除去する事で可視化が可能になります。千代田化工建設はこのノイズ処理技術でコニカミノルタ社の「ガス監視ソリューション」を支援させて頂きました。このカメラをロボットに搭載していくことで、ロボットが人間の感知を遥かに越えることができます。

また、オペレータが現場指示計のデータを見て、この状態を無線機で中央制御室のオペレータに口頭で伝える際に、例えば指示値が波を打つように変動していた場合、これを口頭だけで正しく伝える事は難しいです。しかし、ロボットなら現場指示計を撮影し画像解析をして、指示計の状態を数値データとしてリアルタイムでアップロードすることが可能です。

もう一つ、現場オペレータ周りの情報取得における重大な欠点は、「形式知化」されていないということです。人間が視たり・聞いたり・触れたり・臭いを嗅いだりする時に、人に拠ってその捉え方に大きな差異があります。つまりこれらを「形式知化」することが難しい。このことが、今後現場とデジタルツインを連携させていく時に大きな障害になるのではと考えています。

8.DXに必要な形式知化 (2)ベテラン作業者でもわからないこと

さらに、人からの情報取得が「形式知化」されていないことの例を説明します。

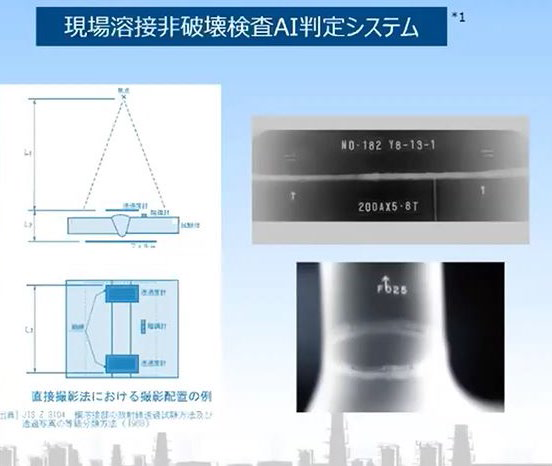

5年前に、社内で「プラント現場溶接における非破壊検査のAI判定システム」の開発実証を行って特許を取得したのですが、その時に判明したことがあります。

このX線写真での溶接合否判定は、非破壊検査の認定資格者によるJISの検査判定基準に従った厳格なものですが、資格を持たない素人では見落としてしまうような僅かな不具合でも正確に認識した合否判定となっています。この写真の中で小さい矢印で示されている箇所が不具合箇所なのだそうですが、とても素人では判別しづらいレベルです。

これらをAIに学習させるのですが、最初の段階では、溶接部のX線写真とそれについての有資格者の詳細な判定結果としてトレーシング・ペーパ上に彼らが発見した不具合箇所を記した学習データを準備して、それらをAIに学習させました。そしてそこからAI学習用のデータを増やして行くにつれて、AIは判定精度を徐々に上げていきました。

そして驚いた事に、学習のために教師データを作成したA、B、C 3名の有資格者のそれぞれの合否判定基準が「甘い」「厳しい」「中間」と、明確に3つに別れることをAIが判定したのです。有資格者がJIS基準に沿って細かく検査をしていても、人間の視覚による判定では大きなバラツキが出てしまうのです。それが判りましたので、その後は教師データの品質を揃えるようにして、さらなるAI学習をさせました。

この結果が示すことは、たとえ資格を持つ専門家がJIS基準に準じて判断していたとしても、その合否判定結果にはかなりバラツキがあるということです。一方、未だ余り学習が進んでいないAIであっても、明確にぶれない「形式知化」されたAI判定ができるということです。つまり、残念ながら、情報を取得して活用するために必須な「形式知化」は、人においては個々の感覚の違いによるバラつきが大きすぎて不可能であることが判ります。

9.プラント保守の課題を解決する自立巡回ロボット

これまでの事例を踏まえて、改めて「プラントでのデータ収集&活用の課題」を考えてみます。

現在のプラントではできるだけ多くのセンサーを設置して多くのデータを収集していますが、しかしその結果データが過剰になってしまって問題が生じていると前述しました。この課題解決策は、制御性を確保しつつデータを適正量にすることです。そして、もしデータを適正量にすることができればセンサー等がスリム化できますので、設備投資および保全コストの削減につながります。

一方、近年のデータ過剰状態は既に人間の判断能力を越えてきてしまっており、人間による複雑なケース判断が困難になっています。また、オペレータの経験が少なくなってしまっていることも、この状況に追い打ちをかけています。この課題解決策としてオペレータの判断支援システムが必須です。そしてもしこれを克服することができたとすれば、このことが将来のプラント自律運転への足掛かりとなるでしょう。

さらに、我が国の石油化学プラントは建設時から数十年が経過して経年劣化が進んでおり、配管・機器からの漏洩、機器の異常等がプラントの重大事故に繋がるリスクが増大しています。その対策として、経済産業省はデジタル技術の活用による保安力向上を目指し、2017年よりスマート保安技術を推進しています。わが社が考えるこの課題の解決策は、プラント内で生じる経年劣化の予測です。さらに、経年劣化を含めたプラント全体のリスクを常時ダイナミックに管理することが期待されていて、先ほど紹介したわが社の装置監視AIはその一つのソリューションとなります。

経年劣化に対しては、従来、オペレータによる巡回での対応をしてきましたが、これを長年支えてきたのは高専・高等専門学校が輩出した多くの人材でした。しかし現在、プラントという3K職場よりも、ロボットSIerが急速に活躍し始めているFA工場の製造ラインのデジタル化に若者の興味が集まっていると聞いています。今後、プラント業界では経験者の不足が増々深刻になるでしょう。何かしらのオペレータ支援案および代替案が必須であります。しかし一方で、この課題を克服できたとしたら、その対応策はそのままプラント現場での省力化および無人化に繋がります。

ベテランによる現場巡回の必要性は今後ますます増加していきます。しかし、人の五感のオンライン化・形式知化が大きな課題として立ち塞がります。一方で、この課題を克服できれば、現場の全ての様子を仮想デジタルツインに取り込むことに発展し、全てのデータがリアルと仮想プラントデジタルツイン間で繋がることで、価値が爆発的に上がります。

また、スマート保安が成立するためには、配管や機器の状態監視・異常の早期発見のための新たなセンサー設置の必要性が増加します。例えば、漏洩箇所の画像検知、音響によるポンプ等の異常検知などのセンサーが必要になりますが、固定費を増やさないためのハードセンサのソフト化が設置の課題となります。これは、先ほど出てきましたテスラ車の話と同様です。一方で、ソフト化が発展することで、プラント設計そのものの簡素化がなされ、プラント操業そのもののフレキシブル化が進みます。

これらの課題解決に向けて自律ロボットの活用が不可欠であり、また、プラントデジタルツインやAIとの連携が必須であり、それらをシームレスに繋ぐ必要があることが、徐々に皆様の頭の中に浮かんできたのではないでしょうか。

10. 自律巡回ロボットがプラント業界にもたらすもの

多くの石油化学プラントでは既に建設から長い年月が経って老朽化が進んでおり、現場オペレータが五感を働かせて異常の前兆を感知して対応し、これまでなんとかプラントの安全と品質を維持して操業を続けてきました。しかし、近年のベテラン・オペレータの減少と経年劣化リスクの増大から、その抜本的な対策は業界内で共通の課題であります。よって、スマート保安技術を活用し、配管や機器の状態監視、異常の早期発見を目指すことを考えなければなりません。

しかし、製造品の付加価値がそれほど高くない古いプラントにおいては、センサー設置等の新規ハードへの投資は到底出来ないというのがプラント事業者側からの切実な声であります。老朽化したプラントでは、いつ、どこで漏洩トラブルが起こるか判らず、全ての疑わしい箇所に新規にセンサーを設置するとしたら、それは膨大な出費になってしまいます。

この根本的課題に対し、「デジタルツイン環境下におけるロボットによる自律巡回監視」が可能になるならば、課題解決できるのではと考えます。これは、これまで日々の巡回監視においてベテラン・オペレータが五感と経験により異常を予知して対応してきたことを、プラントデジタルツイン環境下でのロボティクス活用に置き換えるという案です。

デジタルツイン環境やロボットは、将来はサブスクやリースでのサービス提供となるでしょう。そうなると、デジタルツインのソフトウェアも、ロボットの本体そのものも、常に最新にアップデートされていくことになり、プラントオーナーはもうこれらのシステム更新で悩むことはなくなります。勿論、テスラのソフト化で述べた課題、通信スピード遅延やウィルス攻撃問題等は時間と共に解決されることを前提とした話です。つまり、自律巡回ロボットの活用は、プラント設備のソフト化、そして流動資産化をもたらすものとなるのです。

なお、近年、プラントの中央監視制御システムについても、米国を中心にオープン化の検討が進んでいます。そのオープン化の流れで、いずれは各プラントに設置してある膨大な数の制御監視システムやキャビネットが無くなる方向となり、全てクラウド上に移行していくと予想されます。

以上のように、デジタルツイン環境下でのロボティクス活用はプラント業界の共通課題であり、ベテラン・オペレータ不足、プラント老朽化リスク、そして固定設備への投資困難などなどの課題を根本的に解決する対策であることがわかります。これが、プラント業界における大きなDXの方向と言えるでしょう。

11. 自律巡回ロボットの実現に必要なミドルウェア

プラントでのロボット活用は、大きく分けて以下の2つのモードに対応するデュアルユースであると考えています。

1.通常モード:自律して巡回監視を行っている状態

2.非常・緊急モード:レスキューモードの状態

このデュアルユースを実現するためには、ロボットを取り巻く環境とのシームレスな連携を実現するミドルウェアの開発が不可欠であります。

わが社は、プラントにおけるデジタル技術活用の一つとして、AI活用と並行してプラントにおけるロボティクス活用の可能性を検討して参りました。2019年からは、京都大学松野先生の研究室と共同で検討を進めています。東北大田所先生のご研究と同様に、京大松野先生も長年にわたって災害時のレスキュー・ロボットを研究開発しています。プラントの通常操業時にはロボットが自律巡回監視を行い、そして緊急時には同じロボットが緊急対応モードに変身するというデュアルユースを目指しています。

わが社の研究開発センターのパイロット・プラントにおいて、京大松野先生と共同でロボットの巡回移動や階段昇降移動、さらに、ロボットによる手動操作バルブの開閉作業等の実証実験を行いました。その後、プラントにおけるロボティクス活用の可能性について、東北大学田所先生とも一緒に検討させていただいております。

その結果、将来に向けて、現場ロボットとデジタルツインとの間での様々なプラントデータの授受を可能にし、AIによる様々なデータ分析を可能にするためには、プラント業界で共通かつオープンなミドルウェアの開発が不可欠であるという考えに到りました。

よって、2022年度のNEDO-SBIR補助金事業で、ヴァレンシア社と京都大学、東北大学、千代田化工建設が連携して、デジタルツイン環境下のロボティクス活用を目指したミドルウェアの開発計画を提案し、採択がなされました。これにより、将来に向けたプラント業界でのロボティクス活用の標準化を推し進めていきたいと考えています。

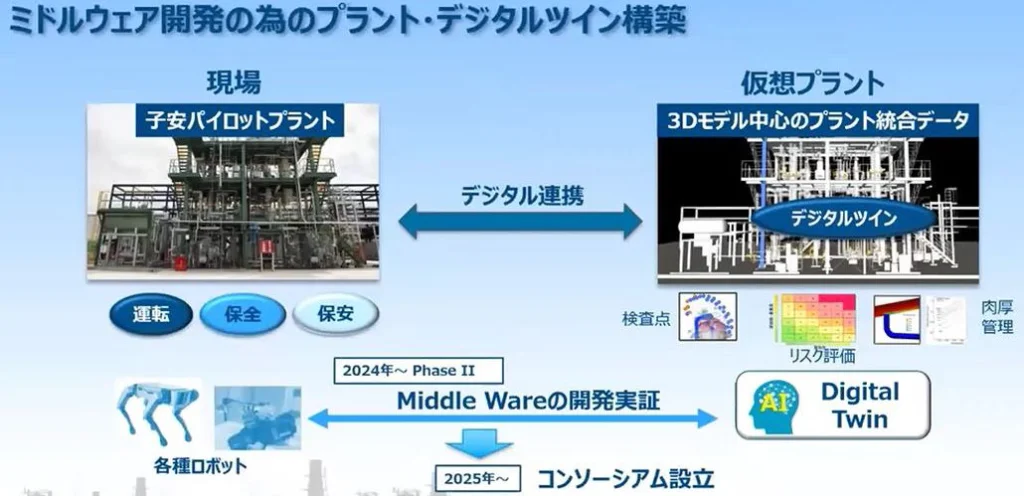

2023年度まではフェーズⅠの開発が行われ、本年2024年度は、わが社の子安研究開発センター内のパイロット・プラントでミドルウェア開発実証の為のデジタルツインを構築中です。

上の図の左側の写真がわが社の子安研究開発センターのパイロット・プラントです。現在は稼働しておりませんが、稼働時の運転データ、メインテナンスデータ等が全て揃っております。よって本年度はミドルウェアの開発フェーズIIとして、本パイロット・プラントの3Dモデルを中心としたデータ統合システム、即ちデジタルツインを構築し、現場ロボットとデジタルツインを繋ぐミドルウェアの開発実証を進めていきます。

ミドルウェアを介し、ロボットに対して3D情報や自律巡回の対象情報などが送られ、一方でロボットからは、自分の位置情報や現場指示計の指示値情報、画像情報等の様々なデータがミドルウェアを介して送られます。

そして、来年2025年度には、本ミドルウェアの実用に向けた展開をはかるべく、NEDO-SBIR事業計画の中でコンソーシアムの設立が予定されており、今後、参加企業や団体を募集していく予定です。

12.自立巡回ロボットのデュアルユース・コンセプト

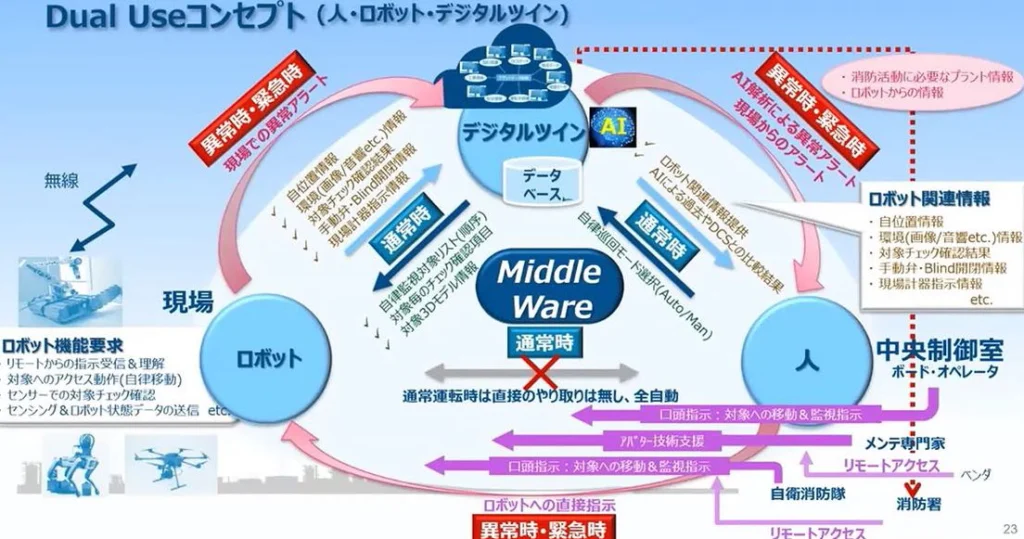

ロボットとデジタルツインを繋ぐミドルウェア開発にあたり、ロボット、デジタルツイン、人、の関係性を示したものが下図です。

図の中で、人とは、中央制御室のボード・オペレータ、リモート支援のメンテの専門家、ベンダー・スペシャリスト、そして火災時での消防士を表しています。

通常運転時は、まずボード・オペレータがロボットの自律巡回モードを選択し、それをデジタルツインに伝達します。指示や経路がデジタルツインからロボットに出され、現場のロボットはプログラムに従った自律巡回監視作業をこなしていきます。ロボットがセンシングしたデータはデジタルツインへ自動的にアップロードされ続けます。それらのデータをAIが過去のデータと比較し、運転整合性をチェックし、デジタルツインはその結果をオペレータに報告します。なお、通常の巡回監視モードではオペレータとロボット間での直接のやりとりはなく、ロボットは事前に作成されたプログラム通りに淡々とタスクを実行していきます。

ロボットが現場で異常を発見した時、あるいはロボット自体に異常が発生した時、ロボットは異常アラートを発し、それをデジタルツインに伝えます。デジタルツインは即座にそれをAI解析して、それを織り込んだ現場からの異常アラートをボード・オペレータに伝えます。

中央制御室のボード・オペレータは異常モードに切り替え、ロボットはオペレータからの指示待機モードに切り替わります。オペレータは口頭やシンプルな操作でロボットに次の指示を与えます。例えば、異常が発見された機器や配管に接近して調べろ等の指示です。メンテ関連の異常であれば、メンテの専門家にオペレータが連絡し、専門家はリモートからアバター支援で現場ロボットを介して異常の確認をします。さらに機器ベンダーにも連絡し、機器ベンダーもリモートから現場への支援をすることが可能です。

一方、プロセス流体の漏洩や火災発生の情報がロボットからデジタルツインに伝わると即座に緊急モードに切り替わります。第一報を消防へ連絡した後、該当箇所のデジタルツイン情報が中央制御室と消防にも送られ、関係者が一体となった迅速な対応がなされます。

このように、石油化学ガスプラント現場でのロボティクス活用では、通常時と緊急時のデュアル・ユースが重要であり、それに沿ったミドルウェアの開発が必須となります。

13.WRS2025 〜ミドルウェアを介したロボットのチーム対抗競技

先ほど田所先生よりWorld Robot Summit(WRS)2025のご紹介がございました。

前回のWRS2020は、Covid19の影響から2021年に開催されました。その中で、プラント災害予防チャレンジでは、福島県南相馬市に建設された福島ロボットテストフィールド施設を用いて、ロボットを使用した様々なタスクの競技が開催されました。日常点検、異常検知、緊急対応など、自律ロボットのプラントにおけるデュアルユースを、できるだけ現実の条件に近づけて競技は実施されました。当時、リアルタイムでYoutubeにこの様子が発信されていましたので私もそれを見ていましたが、まるでリモートで現場を見ているような感覚でした。この動画は今でもYoutubeで見ることができます。

WRS2025では、新たにプラントのデジタルツインのダミー環境を構築し、ロボットとデジタルツインを繋ぐミドルウェアを介してのロボットチーム対抗競技となります。現在WRS2025の準備チームでは、田所先生をリーダーとして様々な検討と準備をしています。今回もリアルタイムでのYoutubeの一般公開となりますので、フィジカル・インテリジェンスの世界をよく見ていただけるように期待しています。現在、鋭意内容を検討中です。

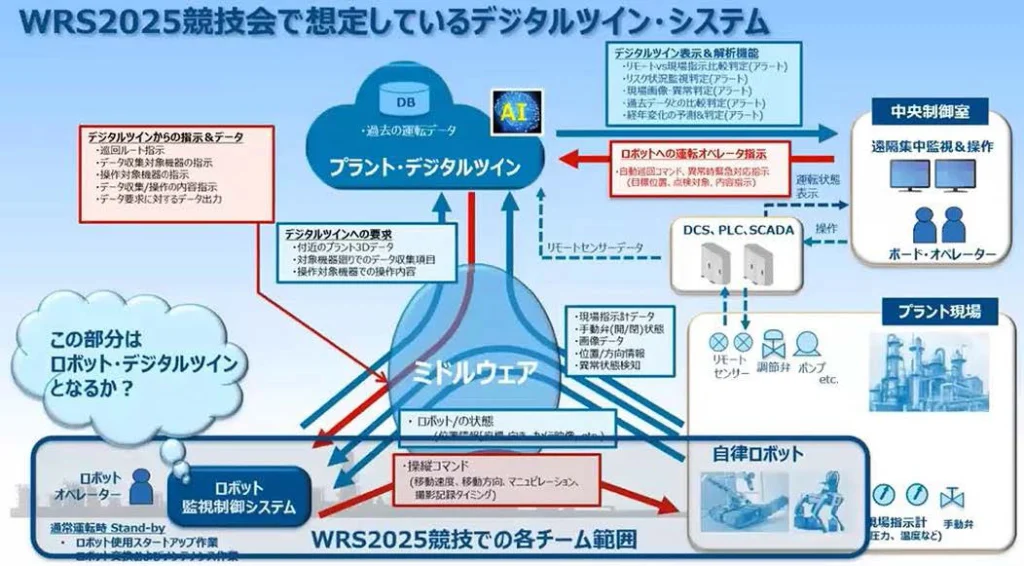

ここで、WRS2025競技会で想定しているデジタルツイン・システム全体について、簡単に紹介します。

プラント現場にてDCS(Distrubuted Control System 分散制御システム)やPLC(Programmable Logic Controller プログラム可能な論理制御装置の意)、SCADA(Supervisory Control and Data Acquisition 監視制御とデータ収集の意)システムが設けられ、中央制御室のボード・オペレータにより、遠隔集中監視・操作が行われており、現場ではオペレータが巡回して、現場指示計を確認、手動弁を操作しています。ここにクラウドでのプラントデジタルツインが構築され、AIによる過去のデータ分析等から異常判定やリスク状況提示をしたり、経年変化の予測や判定などのアラートをボード・オペレータに提示したりします。

この環境の中で、現場オペレータを現場を巡回する自律ロボットに置き換えるとします。現場にこのようなロボットを導入するには、ロボットが自律巡回するためのロボット監視制御システムが必要となります。

一方、通常運転時においても、何かあった時のためにロボットオペレータが待機しています。また、ロボットオペレータは新規ロボットのスタートアップ作業やロボットの交換、メインテナンス等を行います。オペレータの最も大きなタスクは、自律巡回監視の順路を決めて巡回プログラムを作成することです。そして、これらを繋ぐのは先ほど紹介したミドルウェアであります。

まず、ボード・オペレータからロボットに対して自律巡回コマンドを出します。そうすると、デジタルツインとロボット監視制御システムとの間でやりとりがあり、3D情報を伝え、さらに詳細にどこの何をチェックするかを明確に示します。それに基づいて、ロボットへの操縦コマンドが出されます。そして、ロボットからは現場指示計のデータや画像情報などがミドルウェアを通じてデジタルツインへ送信され、ロボットの状態がミドルウェアを通じてロボット監視制御システムへ送信されます。

WRS2025競技会では、将来のこのようなロボット活用の姿を想定して、競技会用の環境システム準備を進めています。なお、WRS2025競技会では、ロボット本体とロボット監視制御システムとロボットオペレータが各チームの構成要素であり、そこで競って頂きます。

近い将来の実用段階では、ロボット監視制御システムとして、ロボット周りの3Dベースの統合管理システム、即ちロボット・デジタルツインというものが新たに設けられたり、もしくはプラントデジタルツインに組み込まれるということになると思われます。

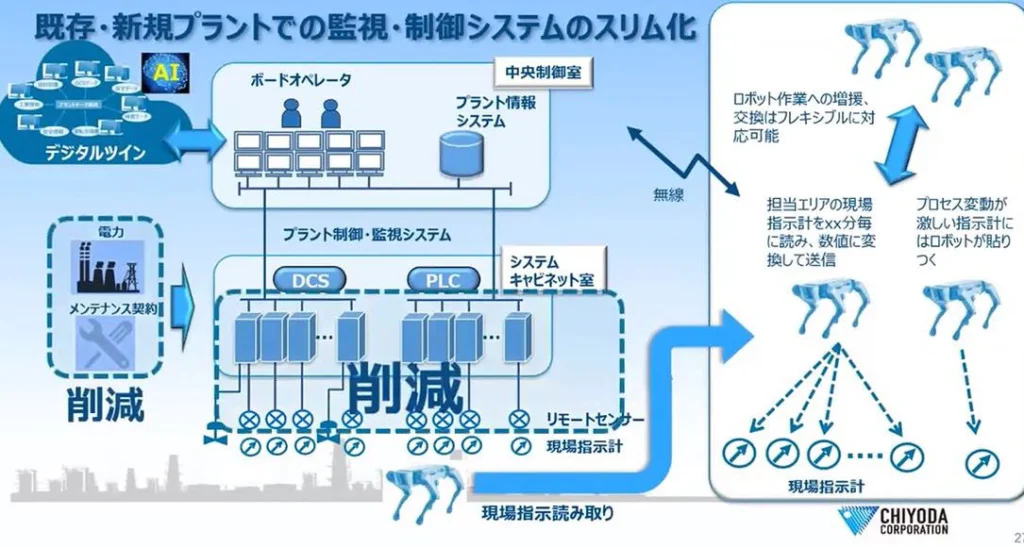

14.“フィジカル・インテリジェンス”が実現するプラントのスリム化

最後となりますが、フィジカル・インテリジェンスの観点から、プラントデジタルツインの未来について説明します。

従来のプラントに、ロボット、デジタルツイン、AI、ミドルウェア等を導入し、フィジカル・インテリジェンスを実現します。例えば、従来現場オペレータが行っていた現場指示計の読取りをロボットが行うことになります。実際には、ロボットは各担当エリア内をぐるぐる移動して周り、それぞれの現場指示計を何分毎かのインターバルで読み取り、数値に変換してデジタルツインに送信することになります。一方、プロセス変動が激しい指示計には、ロボットが長時間張り付くこともあるでしょう。また、ロボット作業への増援・交換は、フレキシブルに対応可能となります。

現場指示計が示す数値をロボットが画像認識して数値に変換してデジタルツインに送信できるのであれば、それで十分だというプラントのケースは非常に多いです。高価なリモートセンサー、トランスミッターやケーブル、システムキャビネットを設けて信号を受ける等々をわざわざ実施しなくてもよいというケースも多いでしょう。

また、これによってシステムが削減できたとすれば、電力消費量の削減、システムメーカへのメンテ契約の削減、そればかりか、膨大な熱量を発するシステムの為の空調設備の縮小、さらに、キャビネットルームの建屋の縮小等々、大きなコスト削減効果が期待できます。

つまりこれは、業界全体が右肩上がりの時代にリモート式センサーを大量に導入した故に、システム周りでの様々なコストが雪だるま式に増大したことに対する逆方向へのスリム化に他なりません。フィジカル・インテリジェンス実現によるこのコスト削減案は、今後、プラント業界を一変するデジタル改革案、即ちDXに繋がるものと期待しています。

15.“フィジカル・インテリジェンス”が実現する将来のプラント設計

では、プラント業界においてフィジカル・インテリジェンスが本格的に導入されたら、将来のプラント設計そのものはどうなるのでしょうか。

石油化学ガス等のプラント設計は、当然のことながら、人が恒常的にオペレーション・メインテナンスを行うことが前提となっています。よって、人が常に安全に作業を行えるような環境とするべく、危険を避ける仕組みになっているだけでなく、作業環境も人に負担をかけないように気を配っています。人的災害が発生した際の計り知れない損害コストと比較して、その対策にコストがかかってしまうことは止むを得ないと考えるからです。

プラント現場において、自律ロボットをフルに活用することで、人の作業時間を大幅に削減したり、ほぼゼロにすることが可能になれば、プラント設計における考え方の前提が大きく変わります。

例えば騒音設計ですが、現在、配管やバルブからの騒音は85dBA(デシベルA 特性)以下に制限されています。そのために、高価な低騒音バルブの採用や、サイレンサーの設置、防音用の施工等々が必要となっています。この騒音対応のコスト増はかなりの負担であり、もしロボットのフル活用によって現場に居る人の時間が少なくなるとすれば、騒音対策費用は大幅に削減可能となるでしょう。

また、塔や槽の設計においては、人が中に入って検査や作業をするためのマンホールを多く設置する必要があります。プロセスがリークするリスクを考えれば、このマンホール設置のための資材コストも致し方ないと考えていました。しかし、機器の中に入って作業ができる小さなロボットが登場すれば、この周りの設計が根本的に変わり、コスト的にも大きなメリットが出てくると考えます。

次に照明設計ですが、現在は夜間でも日中のように明るくするべく、非常に多くの照明が設置されています。しかし、ロボットが主に見回り&作業を行う環境であれば、多くの照明は必要なくなると考えます。

このように、自律巡回ロボットのフル活用により、監視・制御システム設計については大きなコスト削減が見込まれます。

そして、最もコスト削減の貢献度が高いと予想されるのはエルゴノミクス空間設計周りです。ロボットベースの設計であれば、人が通る十分なスペースを確保する必要が無くなります。また、バルブ配置が人の手の届きづらい場所でもよいとなれば、配管設計およびプラントのトータルスペース縮小によって大幅なコスト削減が見込まれます。

ただし、ロボットをフル活用するには、別途、自律ロボットが効率良く作業できるように設計する必要があります。例えば自動給電の場所等です。

いずれにせよ、今後、ロボットをフル活用するプラント設計手法を確立していく必要があります。

16.デジタルツインによるプラントの未来

最後になりますが、上図はデジタルツインを中心とした将来の次世代プラント操業の姿です。

デジタルツインを中心にし、プラント現場でのIoT化、自律ロボットの活用が浸透し、故障や異常は未然に防がれるようになり、特に人的被害リスクは最小になります。また、自律ロボットの活用により、現場の人の周りのデータが形式知化され、リアルタイムでオンライン見える化されることによって、多大な貢献がなされるでしょう。

これにより、ビジネス環境の変化を迅速に捉えて、プラント操業をタイムリーかつフレキシブルに変更・調整することが可能になり、コストセンターであったプラント現場がプロフィットセンターに生まれ変わることになります。

また、協力会社や各ベンダー、官庁等の関連ステークホルダーの間で、デジタルを用いた深い相互連携が一層進むことでしょう。特にDX化された企業グループ同士で新たなデジタル・ビジネスが醸成される流れとなり、次世代のデジタル・エコシステムが生まれてくるでしょう。

一方で、実は、プラントエンジニアリング会社のわが社としては、その先が重要です。

海外の大型プラント建設では、約2万人の作業者が2~3年にわたって現場工事を行っています。プラントが建設されるような通常の住環境から離れた場所においては、2万人が寝泊まりできるキャンプ、朝昼晩の食事、そしてバス100台での作業員の輸送など、間接コストも莫大になります。

プラント建設現場でロボットを活用することができれば、作業員の2万人が1万人になり、建設工事期間も短くなって、多大なコストメリットが生まれるでしょう。しかし、プラント建設現場にロボットを活用することは、操業中のプラントへの活用よりもさらに困難を極めます。

建設中のプラントはあちこちに膨大な足場があり、様々な資材や仮設機器が置かれ、歩くのもままなりません。工事が完了して操業しているプラントでは配管・機器が3Dモデルの通り固定されアクセスも容易ですが、建設中のプラントにおいては日々置き場や形が変わるので、我々のようなプロでも、今自分がどこに居るのか、目の前の製作中の配管や機器は何か等々を見間違うことが多々あります。

また、操業中のプラントにおける自律ロボットのタスクは監視が主になりますので、ロボットにパワーはそれほど必要なく、現場オペレータと共同作業ができます。しかし、建設現場においてはロボットにパワー作業が必要とされるでしょうから、そういうパワーロボット機械と人は同じ場所に居てはならず、いちいちバリケードで隔離しないといけなくなります。そんなことは到底不可能であり、よって、まずはパワーを必要としない監視用の自律ロボットから活用されていくことが予想されます。

以上のように、プラントのライフサイクルでロボットを活用していくことに関しては、まだまだ多くの課題があります。しかし、3Dモデルベースでのデジタルツインとロボットを、ミドルウェアを介して連携していくべきだということは、ずっと変わらない流れです。

皆様におかれましては、ぜひその基本的な流れをご理解いただき、将来に向けた推進への御支援をいただきたい次第です。

Ⅳ.パネルディスカッション

司 会: 大槻裕志 ㈱現代経営技術研究所 所長

パネリスト:

田所 諭氏 東北大学大学院情報科学研究科応用情報科学専攻 教授

井川 玄氏 千代田化工建設㈱ 参与 フロンティアビジネス本部 デジタル担当

泉 秀明氏 東北大学大学院工学研究科技術社会システム専攻 特任教授 ㈱現代経営技術研究所 シニアコンサルタント

ロボットのエンターテイメント化の方向性

質問:フィジカル・インテリジェンスは面白い概念だと思います。これからエンタテインメントの方向に行くことは考えていらっしゃいますか。たとえば楽器を演奏する等です。

田所:私自身は、レスキュー・ロボットを中心として厳しい環境の克服を主たる研究の場としておりますので、エンタテインメントの方向性は考えていません。しかしながら、同じ技術を使って、例えば東北大学の昆陽雅司先生は触覚を中心としたインテリジェンスのXRへの展開研究をしておられ、エンタテインメントも一つの方向性であります。

レスキュー·ロボットに用いるプラットフォーム·システムの在り方

質問:ミドルウェアを活用した関連ソフトの標準化、共通化は重要な課題だと思いますが、ロボットの世界でデファクトとなっているROS(Robot Operating System)に関しては、プラントシステムの立場からどのようにお考えでしょうか。

田所:ROSは研究者にとってはスタンダードのプラットフォームで、ほとんどの研究成果はそこをベースとしてつくられています。最近になってROS2というのが出てきまして、セキュアなシステムにようやく進化したので、ビジネスでも使えるようになったと言われています。

しかしながら、ROS2もまだまだ使えないという企業もあります。プラントのようにセキュリティが問われる現場でどれだけこれが使えるのかは、これからの課題ではないかと思います。

要するに、ロボット・セキュリティをどれだけしっかりと考えられるか、また、信頼性をどれだけ考えられるか、ということだと思います。

開発速度という点では、明らかにROSを使った方が10倍速く同じ機能を実現できますので、これをどのようにして使っていくかというのは非常に重要です。

井川:今のミドルウェアの開発の話は、まずプラント向けにという事でやっています。つまり、先ほども申しましたが、プラントにはもの凄い数のセンサーがあり、いろいろな継時変化などをチェックするポイントが何千何万ともの凄く沢山あるわけです。プラントの場合はそれらが理路整然とアイデンティフィケーションされて3Dモデルにリンクしているわけです。その膨大なやりとりに対してルールをつくらないと、なかなかデータとロボットをデジタルツインにできません。

私のイメージでは、ロボットをリースした時に、そこのシステムを理解することができるか否か。そのプラントの機器とかセンサーとかいろいろなものの番号を管理するルールがあって、ミドルウェアがそれを前提につくられていれば使えるのです。

ロボットの動作についてはROSでよいと思いますが、それをもっとプラントに適したものにすることがミドルウェア作成のポイントだと思っています。

レスキュー・ロボットのビジネス化 (1)常用と非常用の両立が必要

大槻:それではパネルディスカッションに入ります。泉先生、まず最初に問題提起をいただけますか。

泉:お二人とは普段からざっくばらんにいろいろな話をしているのですが、今日は改めてお二人のプレゼンテーションを公式うかがいました。レスキュー・ロボットは非常時に使います。ロボットは機械ですから、機械はやはり定常時でも使い続けていることが基本です。

レスキュー・ロボットを念頭に置いて田所先生は研究開発をされていますが、レスキュー・ロボットを非常時にしか使わないということになると、1年にせいぜい3回か4回くらいしか出番がない。その時に、すぐ始動できるのかどうか。その点はどう変えていけばよいのでしょうか。

田所:その件につきましては、もう25年ぐらい前から何度も同じことをいろいろなところで話しております。

防災の専門家たちも平時からの連続性は非常に重要だと語ります。それが成立しないと防災の様々なことは成立し得ない、というのがこの世界では常識的な話です。

ロボットの世界で災害現場でうまく使われているのはドローンです。ドローンはビジネスとしては防災をターゲットとして成立しているわけではなく、もっと別なドメインで、例えば写真撮影であったり、あるいは土木工事であったり、そういったところをターゲットとして成立しています。しかしながら、自治体と企業とが協定を結んでいて、緊急事態になると企業は直ちにドローンを出動させて現場の調査が始まります。それによってお金も支払われます。そんなふうに仕組みとしてでき上がっていて、従ってドローンはビジネスとして成立している上に緊急時にもすぐ使えるという状態にあるわけです。

一方で、例えば今日ご覧いただいた能動スコープカメラみたいなものは、現実にドローンのように配備されているわけではない。なぜ配備されないかというと、それに即した工事とか建設とか、あるいはさまざまなニーズがまだそれほど顕在化していないからです。

能動スコープカメラがあることによってできることは沢山ある筈なのですが、今までそれができてなかったがために、結局緊急時に出動するための制度化もできていない。従って、買う理由がないわけです。だから、能動スコープカメラは企業に配備されていないし、ビジネスにはならない。だから緊急時にすぐに出動する状態になっていない。もしも緊急時に能動スコープカメラを出動させる必要があるなら、それは専門機関に配備することになります。消防署に配備しようということになると全国の消防署はせいぜい数百しかないのです。従って、そんなに沢山売れるものではありません。だからビジネス的にはなかなか成立し得ない。そういう堂々巡りになってしまうのです。

レスキュー・ロボットのビジネス化 (2)産·官·学、それぞれのなすべきこと

田所:研究開発が大学の生業ではあるのですが、レスキュー・ロボットの配備がビジネスとして成立するように、その調達のメカニズム、あるいは社会にそれを実装するメカニズムをしっかりと整えていく必要があります。ドローンのように商業ベースでのメカニズムが整うことを待っていたのでは遅くて、政府主導あるいは業界主導で何らかのメカニズムをきちんと導入するべきです。

環境問題は本来儲からない筈なのに、なぜか儲かるようなしくみに上手くメカニズムが整備されている。同じように緊急時の安全性の確保のためのロボットを社会で共有するメカニズムも整備されるべきです。

泉:私が2019年に京都大学のインキュベーション・プログラムにおいて松野先生とタッグを組んで起業しようと動いた時に、消防署や自治体など、公共性を有している機関に働きをかけたのですが、今、田所先生が言われたような展開になりました。

クローラ型のロボット(能動スコープカメラ)は、プラントのメインテナンスに使えるのではないかとアプローチしました。ロボットの中には四つ足走行、クローラ型等いろいろな種類があるわけですが、実際のプラントに適用するとなるとなかなか難しいところがある。

向こう30年の間に70%の確立で大震災が起こるのは分かっているわけですから、国の制度としてきっちりと考える必要がある。日本は災害予測地域の周辺部に約千二百箇所くらいのプラントがあるらしいのです。そうなると大変な問題になることが想定されている。国の制度としてお金を出してきちんと災害に対する備えをしておくことが必要です。このことを行政に申し上げたことがあるのですが、しかし、なかなか制度化はされないですね。

レスキュー・ロボットのビジネス化 (3)現場で必要とされているもの

井川:2つあります。

一つは、消防隊員の現場作業はかなり危ないのです。ですから消防隊員の身を守りたいという優先順位がまずあります。例えば石油プラントで火災が起こった場合には、バルブを閉めて燃えるものは全部燃やすだけ燃やすという処置がとられます。その時、一番近くまで行ってバルブを閉めて、残った石油を燃やす作業をするのは消防隊員です。その燃焼がいつまで続くのか、あとどれだけ消火剤が必要なのかが分かりたいのです。それから、危ない箇所はどこなのかという情報を知りたいわけです。消防隊員の安全という意味では、ロボットが消防隊員よりも前に行くことが望ましいのです。

このような要望に応えるためにも巡回監視と非常緊急対応のデジタルユースのロボットを実装したデジタルツインが必要になります。

もう一つは、今GXでわが社も絡んでいる案件です。タンクにはアンモニア燃料を大量に貯蔵してありますが、実はアンモニアのタンク周りはものすごく危ないのです。そこにはとても人は近づけないので、そういうところこそロボットしか行けないのではないかと思っています。

大槻:フィジカル・インテリジェンスという概念で捉えて、その中にレスキュー・ロボットを位置付けることが道を開くことになると思います。レスキュー・ロボットと呼ぶ前に極限作業によって鍛えられたロボット、それがネットワークでつながっていくロボット、しかも複数のロボット同士や他の機器ともネットワークしながら繋がって集団知能を形成するロボット。そういった次世代のロボットシステムとして広く認知されていくことがビジネスへとつながっていく可能性を高めるものと考えます。

その観点から例えば能動スコープカメラは、デジタルツインが実装されていくにつれて大きなニーズのもとで成長する可能性があります。そこでは配管の中をちゃんと見て診断したいというニーズが沢山生まれますから。製造業なりプラント業なり、そういった業界の作業者は絶えず危険と隣り合わせの中で仕事をしているのですが、そういった中にデジタルツインと連動して能動スコープカメラは自然と実装されていく存在になるのではないかと期待しています。ですから、開発者の皆様にとってこれから素晴らしいことが起こるのではないかと確信しています。

“フィジカル·インテリジェンス”実現のシナリオ

大槻:ところでメールのやり取りの中で井川さんが面白い論理を展開してくれました。紹介させていただき皆様と共有したいと思います。

フィジカル・インテリジェンスが実現されているプラントにおいては、現場にロボットが導入されるやいなや『知能集合体が実現する集団知能』の一部としてフル稼働するでしょう。つまり、あるコンビナート地域でロボットを各プラント事業者にリースしメインテナンスする新たなビジネスが生まれるでしょう。

そして、そのサービスを提供する企業は、ロボットを利用可能とすべく、ロボットSIerも多数抱えて、プラント事業者に対するロボット制御監視プログラム作成、監視も請け負うことになりましょう。そしてその先には、プラントの保守、保安管理作業自体も一括で請け負う方向にビジネスが発展し、行く末は『総合O&M(Operation and Maintenance)企業』が生まれることになるでしょう。なお、これが実現する前提は以下の通りです。

●プラントデジタルツイン・フィジカル・インテリジェンスにより、プラント操業でのノウハウが見える化・形式知化されていること。

●プラントのリスクを常に監視して必要な合理的アクションが一義的に示されること。

●全てのロボット状況を把握し適切な指示ができること。

等です。

これにより、あるコンビナート地区において、上記が全て見える化されることになれば、一つの『総合O&M企業』がプラントO&Mを請け負うことがコスト的にも最適であることは確かです。

ロボットと人間のヘテロジニアスな集団知能

大槻:井川さんのメールは、以下のように続きます。

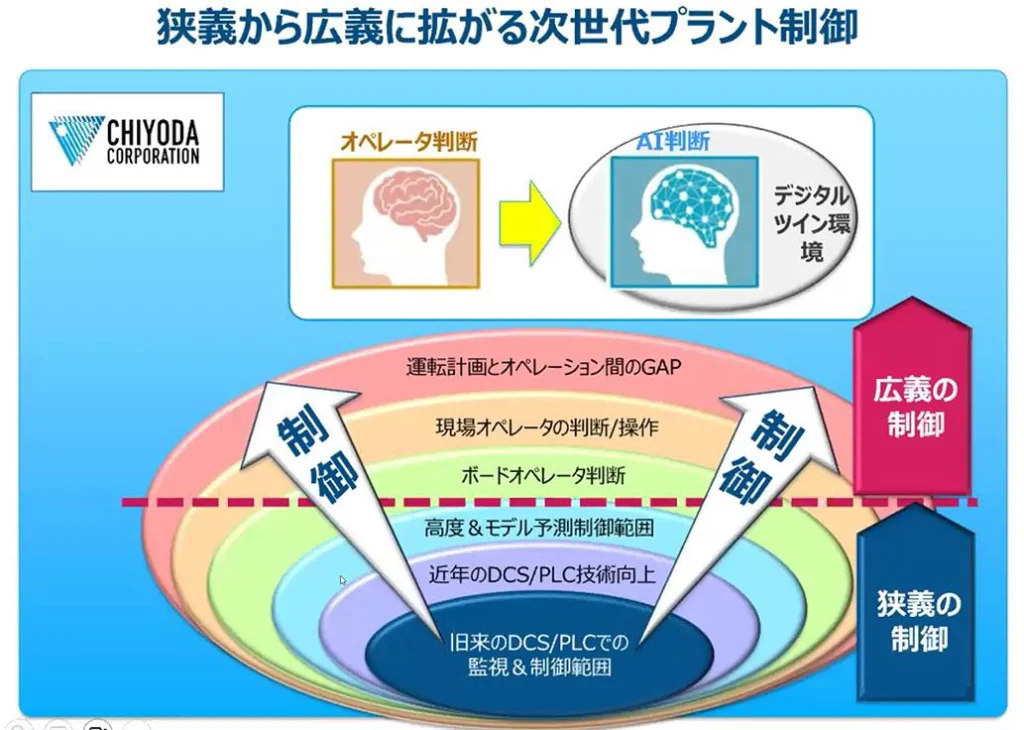

制御の発展形:ロボット単体の知能ではなく、人間を含むヘテロジニアスな知能体が実現する集団知能、ということに関して、

制御システムエンジニアが、数千個のリモート計器を選定し、プロセスプラントの配管・機器・回転機等に設置、そしてそこから1秒毎、振動等はmmsecで上がってくる信号を監視し、設定通りの運転になるべく、コントローラーで調節弁等をフィードバック自動制御すべく、分散制御システムを設計することを想像してください。

この自動制御とは、“水道の蛇口を捻って容器の目標レベルまで達したら蛇口を締める”という人間が『眼で見て』、『頭で判断』し、『(蛇口を捻るとかの操作)アクションをする』というフィードバック制御を、システムで自動化したものにすぎません。

となると、プラントにおいて、様々な配管・機器の寿命を予測し、計器センサーの信号や、かつ表面の錆の具合等々から、人間が『眼で見て』、『頭で判断し』、『(経年変化に対する)アクションする』ことも、一つの『制御』であります。

様々な計器のセンサーの信号や、現場の状況(画像・音響・振動・臭いなど)をロボットに搭載したセンサーからの信号から得た、膨大なビッグデータからAIが『データを見て』、『分析し』、『危険の事前回避のアクションをリコメンドする』ことも、一つの制御です。

これをまとめたのが、添付の『狭義から広義に拡がる次世代プラント制御』です。この狭義の制御から広義の制御に発展する時、まさに『ロボット単体の知能ではなく、人間を含むヘテロジニアスな知能体の集合体が実現する集団知能』となりましょう。

人間からロボットへの移行から生まれる爆発的価値

大槻:それがこの図です。オペレータ判断からAI判断へどんどん移行していく、ということが示されています。

大槻:最後に井川さんのメールの最後の結論部分を紹介します。人間からロボットへの“繋げる”機能の代替が生み出す“爆発的価値”ということです。

『集団知能』と、(プロセスプラント現場などの)“リアル”との間は、リモートセンサーや現場オペレータの知覚・操作、そして中央の制御室のボードオペレータが“繋げて”きました。

この“繋げる”を考えてみましょう。

プラント現場でのロボット活用は、まさにその“繋げる”部分を、人間からロボットに大幅に移行するものであり、今後、ロボットがカバーする範囲は急速に拡大していくでしょう。

人間からロボットに徐々に代替していく時、ここに大きな違いが生まれます。

人間は一つの脳だけを有しており、人間同士のコミュニケーションも、人間と自動制御システムとのコミュニケーションも、全て一つの脳とシステムとの“オフライン接続”です。また人間が関与するコミュニケーションの不確かさはぬぐえないものであり、さらに“脳”同士が“オンライン接続”したとしたら得られるであろう、爆発的な価値は得られません。

一方、人間からロボットに徐々に代替していくと、“脳”の部分は、リンクされた集合体の中では、“どこにあっても構わない”事になり、それが“知能集合体”のフレキシブル性を増し、また100%確実な超高速でのデータ授受が可能になり、爆発的価値を生み出すことになりましょう。

このように、井川さんは予言しています。私はこの予言は未来を言い当てているのではないかと共鳴しているのですが、田所先生いかがでしょうか。

田所:私も基本的に同じように思っています。

本日、「空間エージェント網」という概念を紹介しました。この概念は一般性を有しています。物理的な空間、機能の空間、組織の空間、そういう様々な空間にどのようにエージェントを配置していくのか。それぞれのエージェントとエージェントの間でどのように協力をして機能を発現させていくのか。どのようにして空間を変えていくのか。そこが非常に重要なポイントで、今私は一般的な言い方をしておりますが、これをプラントという視点で捉え直すと、まさに井川さんが今述べられたようなことになるのだと思います。

ただ、プラントだけを見てみると、これらは平常時には成立するわけですが、緊急時になりますと、通信が全然うまくいかない、エネルギーが供給できない、はたまたロボットがそこに辿り着けない、そういった制約が出てきます。このような制約条件下でヘテロジニアスなエージェントがどのように協力し合えるかが問われることになり、この辺りが研究テーマとして面白いと思います。時間はかかるかもしれませんが、実用性はあるものだと思います。

ロボット普及後の未来、人の役割はどこまで残るか

泉:人のコミュニケーションにおいて、なぜデジタル化が進展するかということを考えるわけです。

人が限定合理性ゆえに機会主義にふるまうこと。これは、人が間違った判断をするということが前提なのです。その前提の上でコミュニケーションを取らなければいけない。

だからロボットに任せた方がいいのではということになる。デジタルツインが進んで行く理由としてこの点を工学的に詰めていくと、井川さんがおっしゃっていることに至るのだろうなと私も思います。

けれども、現実にそこに人が介在して、人が意思決定をするという、そういった現実面を考えた時に、なかなか全てをAIに任せるわけにはいかない。やっぱり人がいて人が介在して、人にある程度の判断を委ねながら進んで行くというのが、恐らく今後のビジネスの進展の姿なんだろうなと、そう思うわけです。

カーツワイル氏が主張している2045年のシンギュラリティ問題で、AIがやがて人間の知能を超えてしまうのではないかということが言われているのですが、そうではなくて、私はやはり人が現実的な判断をして、人が意志決定するということが続いていくのだと思っています。ネットワークで脳が繋がる等いろいろ言われていますが、遅々として進んで行かないのではないかなと思います。

井川:私は逆です。

AIは変わっていくと思います。今日は生成AIの話をしなかったのですが、孫正義氏も含めてさまざまな人が生成AIに自分の考えを入れて、AI同士で議論をさせて、人間はそれを聞いているというパターンになっています。どんどんどんどんAIは進んでいきます。

人間が人間らしくあるのは、不安定さを内包していたり、一人一人感じ方が違うとか、そういう要素と切り離せません。きちんと仕事をやるということに関しては、人間に代わってAIがこれから本当に出てくると思います。

泉:私が研究対象としているのは建設業界では、施工に関していろいろなロボットの投入が進んでいます。

例えば清水建設では、施工代替ロボットと施工管理ロボットを分け考えています。施工代替ロボットとは、いわゆる天井とか鉄骨とかそういった大掛かりな作業をするロボットです。鹿島建設は、「人とロボットが共存することで施工していく」と言っています。

建物というのは、隅に行けば隅に行くほど定常作業の繰り返しができにくいのです。そういった人の手でなければ作業ができないところが、この先もかなり残るでしょう。大空間での力仕事は恐らくどんどんロボットに代替されていくでしょう。ただし、細かいところは残るので、やはり人とロボットの共存が必要だということを言っているわけです。

私はむしろ鹿島建設が言っていることが最適解だと考えます。

人とロボットは、向こう50年くらいは共存をしていくのではないか、というのが私の考えているところです。

未来への懸念-頭脳労働はAIに、肉体労働は人間に

田所: 今まで、ロボットというのは肉体労働の困難な部分を代替して、人間は頭脳労働だけすればいいという目的のためにつくられてきたと思うのです。ところが、実は未来のロボットは逆で、難しい頭脳労働は全てロボットが担当して、人間は肉体労働だけを担当するようになるんじゃないか、と言っている人も出てきています。

なぜかというと、今AIで実現できている肉体労働は極めて僅かなことしかなくて、ほとんど何もできていないのが現状です。それに対して、いわゆる頭脳労働は、生成AIももちろんそうですが、それ以外でもありとあらゆることが自動化できてしまっている。ただ、人間は責任を取りたいわけです。AIに責任を取らせたくない。あるいはAIが代表者となってほしくない。そういう人間の希望があるだけです。

昔は非常に難しいと言われていたこと、例えば、会計計算は、もう全て自動でやろうと思えば全部できる筈で、もう税金から何から何まで書類のやり取りも全て必要なくなる筈です。社会システム全体をそう変えようとすると大変ですが、ただ、理屈で考えればそれは全部できる筈です。もうそれはそういう方向に向かっていくと思うのです。

そう考えた時に、本当に残る労働って何なんだろうか。実は社会システムを支える労働の中では、頭脳労働よりも肉体労働の方がはるかにボリュームが大きくて、できないことだらけです。だから、これからのロボットの在り方をいろいろと考えなければいけないと思う次第です。

「動き回るセンサー」という価値の有用性

大槻:ビジネス的な観点から一つ申し上げます。田所先生「動き回るセンサー」という表現をなさいます。産業用ロボット以外のロボットで実用化できているのは計測機能。ロボットが自分から見に行ける機能。ドローンもそうですし、田所先生がつくっておられる能動スコープカメラもそうです。

ダイナミック・ロボティクス社のロボットがドアを開けてもう一台のロボットを招き入れる、そしてもう一台のロボットが招き入れらた部屋に入っていく。こういう映像をWEB上で見たことがあります。ロボットが自ら移動してドアノブに手をかけてドアを開けるのは相当難しい機能です。しかし、社会的には何なのだろう。ドアを開けたから何なんだ、ということですね。これはロボットにしては確かに凄いことですが、人間なら子供でも苦もなくやっている。

物理的に何かを動かすという仕事にはロボットが価値を生むニーズは大きくなくて、先ほど井川さんが紹介なさった空間の化学物質を色付けする機能などのように、センシングする機能は産業界で今すぐ実用化したいというニーズが大きいものだろうと思います。

井川:わが社のプラントの建設現場は、最後にベンダー・スーパーバイザが来てチェックしないといけないので、彼らはものすごい数の立会検査に行くのです。ベンダー・スーパーバイザはとても単価が高いのですが、立会検査のためにものすごく時間を使ってしまうのですね。それってかなり無駄なことです。立会検査をする側もされる側もお互い無駄なのですが、これがリモートでできればものすごく有意義です。

わが社で海外現場の立会いをしました時に、現場にカメラが置いてあるのですが、我々は立会検査員なのでそのカメラに触れることはできず、ただ見るだけなのです。それで、カメラの位置を動かしてもらう必要があって、そのためだけに別の人について行ってもらったということがありました。そんな無駄なことをせずにロボットで直接現場を見ることにすれば、今すぐにでもできるわけです。

それで私が思いましたのは、このロボットとデジタルツインを繋ぐミドルウェアの話がもっと広がっていくだろうということです。ミドルウェアを介してリモートで作業できれば、現場が遠くにあってもいいのです。グローバルに展開できる。ミドルウェアを通じて立会検査をする時にはロボットを使って状態が見えるようになる。それはお互いにとってものすごく有意義です。コストが下がるわけです。そういったところに着目したいと思っています

大槻:私は、能動スコープカメラの実用の可能性は高いと考えています。配管の内部等の人間が行けない場所に見に行って高い精度で現実をつかんでくるのは武器になります。この「見に行く」という機能。普通のセンサーは決まった場所に据えるしかないのですが、ロボットセンサーは見たいところまで「見に行く」ことができる。全自動ではなくても、人間が制御しても構わないのですが、こういう機能を実現できる以上、かなりの可能性を持っているのではないかと思います。

同じように、田所先生の研究室で開発された「ぶつかっても落ちないドローン(球殻ヘリ)」「構造物に吸着し長時間働けるドローン(吸着ヘリ)」も社会から求められていると思います。現在も地下鉄などの天井検査をなんとか人からドローンに代替させたいというニーズも高いですから、この方向で計測機能をどこまでも尖らせていったら素晴らしいのではないかと予想します。

井川:私は千代田化工建設として、田所先生に先ほどの能動スコープカメラのお話をしたいです。なぜなら、私もずっと現場で配管などを見ているわけです。その時に何が問題かというと、スコープで見て行く途中で摩擦があって止まってしまうんですね。しかし、今回ご紹介いただいたエアを噴射してスコープを動かしていく仕組みがありましたが、そういうところがものすごく重要でありまして、これは大いに使えると思いますので、また別途お話させてもらいたいです。

田所:ありがとうございます。現場で思うように動き回ることができない場所、例えば狭い所等々が大いにあると思っていまして、そういう問題は恐らく能動スコープカメラに限らず、ドローンも含めて、いろいろな形でお役に立てる部分であると思っています。

ただ、これを遠隔操作でやろうとした時に、それでそこにかかっている人工が減るのかと言われると減らないのです。本当に人がいらなくならないレベルまで自動化できないと人の削減効果が得られない。そうなると問題は格段に難しくなってしまいます。単にセンシングできるというだけではユーザー側にコストメリットが出てこないのです。だからもっとインテリジェントにいろいろなことができないといけないのです。

熟練した技術者に「ここを調べてきてくれ」と頼んだ時に、現場に行って単にメーターを見るとか、叩いてその音を聞いてくるとかだけではなくて、そこで何か異常があることを見出して「これは何々に違いない」と見当をつける。そうすると、「ではここの部分はどうなんだ」と関連しているところを調べる。このように一つのデータセットとして使えるレベルまできっちり調べ上げて帰ってきてくれる。そういうインテリジェントな働きがロボットに求められるのです。

これからのLLM(大規模言語モデル)でも、どこまでフィジカル・インテリジェンスに手段として使えるレベルになるか楽しみです。そういう意味での気の利くアシスタント、つまり、本当に人間が行かなくても大丈夫になるような気の利くアシスタントとして、熟練者に近いレベルのインテリジェンスをロボットがどう実現していくか。ここが本質的な問題となっているように思います。

大学の研究成果を実用化に繋げていくためには

井川:田所先生にお聞きしたいことがあります。

プラントロボットの防爆タイプはExRobotics社のExR-1と三菱重工のEX ROVERの2つしかないと思いますが、大学でロボットの動きやシステムの研究をされている中で、それをプラントに適用する場合に、実際のプラントの環境等をどのようにお考えなのか。先ほどのミドルウェアはプラントでも使えると思いますが、ロボット本体に関してはそう簡単にはいかないでしょう。大学の研究から実際の規格に合ったロボットの開発までのシナリオを、先生はどのようにお考えかをお聞きしたいです。

田所:防爆として知られているロボットがもう一つあります。ANYbotics社のANYmalという脚型の4足ロボットがあります。これがどこまで防爆の認証を取れるかわからないのですが、存在はします。しかし、プラントの防爆ロボットというのはやっぱりその3つしかないというのが世の中の現状です。

ご質問に関しては、何を研究対象とするかによります。我々大学ですと、博士課程の学生はドクター論文を書かないといけない。それができないとなると、もうその研究ができませんという話になって、テーマの整理をせざるを得なくなってしまいます。防爆技術を研究の生業として研究できる人がいれば、その人はしっかりとそこをやるに違いありませんが、そうでなければ多分誰もやらないでしょう。

ベンチャーとしてスピンアウト企業をつくってANYmalみたいなやり方でアプローチする人はいるかもしれません。それは企業やユーザーのニーズを踏まえた上でのビジネスとしてやられる仕事であると整理されるでしょう。ですから正確には誰もやらないというよりは、それはビジネスの世界で扱う領域であると整理される方が実態を反映していると思います。

井川:ありがとうございます。防爆をつくるという技術自体は既にこなれていると思います。ところが、田所先生がやられている研究テーマまで行きますとなかなか大変で、シナリオの終着点にたどり着くのは大変だと思います。もちろんどういうマーケットにその技術を適用するかということは大切ですが、先生がされている大学の研究と実際の防爆をつくる技術がガッチリ組み合うという、そこの仕組みが大事かなと思っています。

田所:そうですね。ソフトウェアはそういうことがやりやすいです。例えば、メーカーさんのロボットのソフトウェアの改良を共同研究するとか、そんな形でいろいろなコード化が図られているという事実があります。ただ、ハードウェアの話になると、そううまくはいかないです。新しくつくったハードウェアの防爆検定を取らないといけないという話になります。そうすると検定を取るだけで何千万円というお金がかかります。それを誰がやるのかという話になります。試作品ということで言うと、結局、試作して壊してまた改良してみたいなことをやると、防爆も全てやり直しになります。ですから、なかなか難しいのです。

大槻:もし産学連携でロボット強国を目指すという目的でやるとすると、ある種の大掛かりな評価センターみたいなものを国に投資してもらえるといいのですが。ロボット技術者の人たちが一斉に、企業もアカデミズムもみんなが使えるような、十分な敷地を確保した大掛かりな評価センターみたいなものが本当に欲しいという気がします。

井川:私は海外で仕事をしていまして、日本と欧米と一番違うなと思う点は、第三者の検定機関がないことなんです。そういったところも今後の進展のために必要なことだと思っています。

泉:研究開発をする時に、大学はテクノロジー・プッシュでいきますので、ニーズ・プルで引っ張ってくれるパートナーが必要です。千代田化工建設は大学にとって事業パートナーの立ち位置にいます。事業パートナーと技術サプライ・パートナーの大学が密接に関係を強化しながら進んでいかなければなりません。先ほどの防爆の例で考えると、別途、防爆を担当する技術メーカーの存在が必要です。そういうところと一緒になって研究開発をしていかないと成立しない。大学のテクノロジー・プッシュで動く研究開発だけではなかなか進展はないと思います。

政府の方針は、大学発ベンチャーを意識しており、とにかく企業と組んでどんどん研究開発していきなさいという風に変わってきています。先ほどの評価センターは、もちろん我々は欲しいのですが、国からはそう簡単に資金提供していただけないと考えた方が良いでしょう。それよりも、民間から資金を呼び込んで開発をしていくことが重要だと、大学側の考え方が変わってきています。もちろん政府の方針に沿ってそういう流れになっているという面はあるのですが。

大槻:政府がTSMCの熊本での工場設立に4000億円拠出しました。なんらかの時流にうまく乗ることができれば全く無理なことではないと信じたいです。

泉:むしろ、そういうことをやっていただければいいです。ありがたいです。

大槻:ビジネス界とアカデミズムの両方に席を置いている泉先生ならではのご指摘ですね。

泉:今、世の中には、国のお金で何とかしましょうという動きと、民間に協力してもらって金を引っ張ってきてくださいという動きと両方がありますから。産学連携は、大学と企業の連携のことですので、それぞれやれることを吟味して、協力し合うことが必要です。

千代田化工建設が実現しているモジュール単位のデジタルツイン

大槻:本日、千代田化工建設の「フォーミングAI予測システム」を紹介して頂きました。これはモジュール単位のデジタルツインだと思ってよろしいでしょうか。

井川:そういう捉え方をしていただいて結構です。

大槻:モジュールレベルでいろいろなものをつくっていく。マクロからミクロをつくるというアプローチもある一方で、ミクロを積み重ねていって少しずつマクロに近づいていくというアプローチもあると思うのです。千代田化工建設の試みは、一つ一つがデジタルツインに向けて積み上がっており、デジタルツインそのものの完璧な完成形ではなくても、そこに向けた障壁の切り崩しを本当によくやっていただいているなと、今日は感心しました。

井川:デジタルツインのプロセス側の方は、コスト的に影響があるところから先にやっているのです。今まで経験と勘でやっていたところを形式知化できるとコストメリットが大きい。だからメリットが大きいところから優先度をつけてやっていく。もっと全体的に展開したいのですが、まずはコスト優先でやっています。

究極のインテリジェンス “一対多”問題の解明への期待

大槻:フィジカル・インテリジェンスという田所先生の着想と共に、「タフ・サイバーフィジカルAI研究センター」という貴研究所のネーミングそのものがとても深いと思っています。それで、先ほどタフネスの紹介の中で、「サイバーフィジカルの身体性」という言葉が出てきました。これは哲学的な含意ある表現であり、文明論的にも、21世紀の前半から後半に我々が突入していく過程で凄く大切な概念になるだろうと思って聞いていました。

田所:そうだと思います。ロボットによるセンシングは沢山のことができるようになってきているのですが、それに対して作業をするということはなかなかバリエーションが増えなくて、非常に困っているという状態です。どういうことか。多対一か、一対多かの問題です。

センシングというのはセンサーのデータをどんどん集めてきて、それを処理して、それをあるシンボルに直すという取り組みだと思います。世の中の現象を根本で考えると、例えば原子レベル、分子レベルで様々なことが起きていて、センサーでその部分的なところをごくごく一部分データとして取ってきて、それを集めてそれを解釈してシンボルに直す。そんなことをやっているわけです。これは多対一の関係なのです。だからそれができる。

作業をしようとするとどうなるか。なんか「点検してこい」と言われるわけですが、その点検という一言が極めて深い意味を持っていて、それを分子レベルに展開することができるのかというと、できる筈がないのです。様々な解釈があって、いろいろなことがあり得る。ですから、それを適切に刈り取って、それでこのおじさんが言った「点検してこい」は結局どういう意味で、何をしないといけないかを人間は考える。それで熟練の作業者は、適切にその点検をして、言われたことだけではなくて他の作業もやって帰ってくるわけです。

それをロボットがどうやってできるのか。これは一から多をつくるという話になるので、極めて難しい話なのです。これをできるようにする枠組みがどこにあるのか私にはよく分からないですが、これからのAIの流れとしてこれを解明していくというのは面白い方向性ではないかと思います。

大規模言語モデル、ディープ・ラーニング等が注目を集めていますが、もっと別の流れも当然あって、それらがこれから発展していって、面白い世界になっていって欲しいと願っています。それが恐らく究極のフィジカル・インテリジェンスになるのではないか、言い方を変えると、身体性を備えたサイバーフィジカルが実現するのではないかと展望しています。そうするとその先に、本当に井川さんがおっしゃったような究極のデジタルツインの世界ができあがるのかなという感覚を持っています。

最後に

大槻:本日、東北大学大学院工学科社会システム専攻、東北大学タフ・サイバーフィジカルAI研究センター、そして私ども現代経営技術研究所の三団体共催のもと、フィジカル・インテリジェンスという概念をこの場で初めて世に問うことができたことを大変意義深く思います。最後はこの研究会の仕掛人であり、東北大学大学院特任教授、現研シニアコンサルタントの泉秀明先生に締めくくって頂きます。

泉:私の所属する東北大学大学院工学研究科技術社会システム専攻は、技術と社会、これが関わる接点をどのようにうまく知として昇華して、それを伝えていくかということがミッションです。そのミッション実現の一環として大学が持っている学際的な知を企業の最前線で吸収してもらい、それをビジネスに生かして頂くことを大切に考えています。

そのような観点から東北大学大学院工学研究科技術社会専攻、東北大学タフ・サイバーフィジカルAI研究センター、現代経営技術研究所とまさに産学の研究所とコンサルティングファームが共催し、事業パートナーとしてアカデミズムとのコラボレーションを果敢に推進してこられた井川玄さん、アカデミズムの枠を超えてレスキュー・ロボットの社会実装のために世界的な水準で挑戦を続けておられる田所先生を迎えて展開したこの3時間半はとても刺激的な時間であったと感動しております。そして150名を超える企業とアカデミズムの第一線で活動されている方々のご参加を頂きました。

皆様のご協力のもと意義深い研究会となりましたこと感謝いたします。